Hey Leute, habt ihr schon mal davon geträumt, euer eigenes kleines ChatGPT auf dem Rechner zu haben, wo eure Daten auch wirklich nur euch gehören?

Dann schnallt euch an, denn LM Studio (Stand 25.9 in Version 0.3.27) ist hier, um diesen Traum für Linux, Mac und Windows wahr werden zu lassen! Diese super-coole Desktop-App macht es kinderleicht, Large Language Models (LLMs) wie Llama, Phi oder Gemma lokal auf eurem Computer laufen zu lassen. Kein Cloud-Abo, kein Datenklau, nur pure KI-Power, die ihr selbst kontrolliert. Und für alle die bisher um Huggingface und die Kommandozeile einen großen Bogen gemacht haben direkt Entwarnung: Es hat eine leicht verständliche übersichtliche GUI.

Ich führe euch durch die Einrichtung und zeige euch, wie ihr im Handumdrehen eure eigene KI-Magie entfesselt. Ob ihr schreibt, codet oder einfach nur neugierig seid, LM Studio ist ein echter Game-Changer. Lasst uns loslegen und ein paar KI-Funken fliegen lassen!

Was ist LM Studio? Dein lokales KI-Abenteuer

Stellt euch LM Studio als euren persönlichen KI-Hub vor. Es ist eine App, die auf Windows, Mac und Linux läuft und Open-Source-LLMs direkt von Hugging Face auf euren Rechner bringt. Ihr könnt Modelle durchsuchen, herunterladen und mit ihnen chatten, ganz ohne Internetverbindung oder teure Cloud-Dienste.

LM Studio nimmt euch die ganze technische Arbeit ab. Es lädt die Modelle in den Arbeitsspeicher und stellt eine intuitive Oberfläche bereit, die an ChatGPT erinnert. So könnt ihr euch voll und ganz darauf konzentrieren, Fragen zu stellen oder coole Sachen zu kreieren. Das Beste daran? Eure Daten verlassen niemals euren Computer.

LM Studio installieren: Einfacher als ein IKEA-Regal

Die Installation von LM Studio ist wirklich ein Kinderspiel. Versprochen!

- Hardware-Check:

Euer Rechner braucht etwas Power, aber keine Sorge, es muss kein Supercomputer sein.

- RAM: Mindestens 16 GB sind ideal für die meisten Modelle (8 GB reichen für kleinere).

- Speicher: Modelle sind 2 bis 20 GB groß. Macht also Platz auf eurer Festplatte.

- CPU/GPU: Eine moderne CPU reicht, aber eine GPU (NVIDIA/AMD) macht alles schneller. Mac-Nutzer mit M1/M2/M3-Chips sind hier klar im Vorteil, da ihre integrierte GPU extrem gut funktioniert. Neuere NVIDIA GPUs mit CUDA Unterstützung (RTX aufwärts) ebenso.

- RAM: Mindestens 16 GB sind ideal für die meisten Modelle (8 GB reichen für kleinere).

- Download & Installation:

- Geht auf lmstudio.ai und ladet das Installationsprogramm für euer Betriebssystem herunter. Führt es aus und folgt den Anweisungen. Es ist ein klassisches „Weiter, Weiter, Fertig“-Setup. Startet LM Studio. Ihr landet auf der Startseite mit einer Suchleiste und einer Auswahl an Modellen. Falls ihr den grauen unscheinbaren „Skip“ Button nicht seht, wird sogar direkt ein erstes Modell im Hintergrund geladen.

Das war’s schon! Bei mir hat das alles weniger als fünf Minuten gedauert.

LM Studio benutzen: Modelle entdecken und chatten

Jetzt, wo LM Studio läuft, kann der Spaß beginnen!

- Modell auswählen und herunterladen:

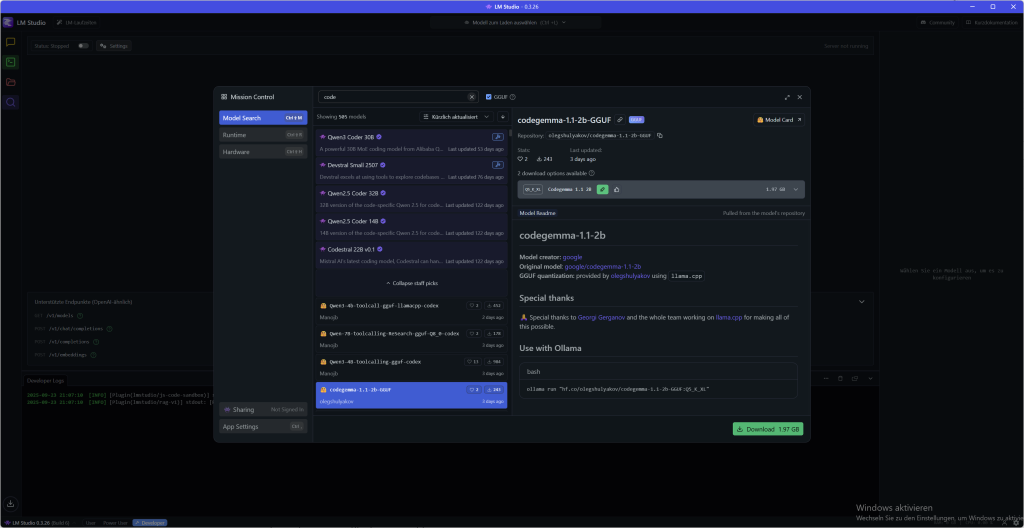

- Klickt auf das Lupen-Symbol („Entdecken“) in der linken Seitenleiste. Das ist euer Modell-Süßwarenladen.

- Sucht nach einem Modell, das euch interessiert, wie z. B. Llama 3.1 8B oder Mistral-7B-Instruct.

- Für Anfänger empfehle ich ein quantisiertes Modell (z. B. eine Q4_K_M-Version) mit 4 bis 8 GB. Die sind schnell und effizient.

- Klickt einfach auf „Herunterladen“ neben dem Modell. Der Fortschritt wird im Tab „Downloads“ angezeigt.

- Klickt auf das Lupen-Symbol („Entdecken“) in der linken Seitenleiste. Das ist euer Modell-Süßwarenladen.

- Laden und Chatten:

- Sobald der Download fertig ist, geht zum Ordner-Symbol („Meine Modelle“).

- Klickt auf das heruntergeladene Modell und dann auf „Laden“. Das Modell wird jetzt in den Arbeitsspeicher geladen.

- Wechselt zum Sprechblasen-Symbol („Chat“) und wählt euer geladenes Modell aus dem Dropdown-Menü aus.

- Jetzt könnt ihr loslegen! Fragt die KI nach einem Witz, bittet sie, ein Gedicht zu schreiben oder lasst euch ein komplexes Konzept erklären.

- Sobald der Download fertig ist, geht zum Ordner-Symbol („Meine Modelle“).

Der Chat fühlt sich genau so an wie bei einem Online-Dienst, aber die gesamte Konversation findet offline statt. Eure Worte bleiben privat und es gibt auch kein Limit und keine Extrakosten für ein Abo.

LLMs herunterladen: Modelle entdecken und auswählen

LM Studio hat einen eigenen Modell-Downloader, der direkt mit Hugging Face verbunden ist. So findet ihr das perfekte Modell für euch:

- Suchen und Finden: Geht zum „Entdecken“-Tab (die Lupe) oder drückt einfach ⌘ + 2 (Mac) bzw. Strg + 2 (Windows/Linux). Ihr könnt nach Stichwörtern wie „llama“, „gemma“ oder „lmstudio“ suchen. Sogar komplette Hugging Face URLs könnt ihr in die Suchleiste einfügen!

- Qualität vs. Größe: Für jedes Modell gibt es oft mehrere Download-Optionen, die kryptisch klingen, wie Q3_K_S oder Q_8. Das Q steht für Quantization, eine Technik, die Modelle komprimiert. Dadurch werden sie kleiner und laufen schneller, verlieren aber ein wenig an Qualität. Für den Anfang wählt eine 4-bit-Option oder höher, die bieten einen guten Kompromiss. Details dazu könnt ihr in diesem Artikel nachlesen.

Einfach das gewünschte Modell auswählen und auf „Herunterladen“ klicken. Der Fortschritt wird im Tab „Downloads“ angezeigt. Übrigens könnt ihr den Speicherort für eure Modelle im Tab „Meine Modelle“ ändern, falls der Standardspeicherort nicht passt.

Das Interface: Vom Anfänger zum Profi-User

LM Studio ist nicht nur ein Tool, es passt sich euch an. Egal, ob ihr gerade erst einsteigt oder schon ein echter KI-Crack seid, die Benutzeroberfläche bietet in der Fußzeile unten links drei verschiedene Modi, die ihr ganz einfach umschalten könnt. So habt ihr immer nur die Funktionen im Blick, die ihr wirklich braucht.

Die Modi im Überblick:

- User Dieser Modus ist perfekt für alle Anfänger. Er zeigt nur die Chat-Oberfläche und konfiguriert alles automatisch im Hintergrund. Hier müsst ihr euch um nichts kümmern und könnt sofort loslegen. Einfach Modell laden und chatten, einfacher geht’s nicht.

- Power User Wenn ihr mehr Kontrolle wollt, ist das euer Modus. Hier habt ihr Zugriff auf alle Lade- und Inference-Parameter sowie erweiterte Chat-Funktionen. Ihr könnt eure Konversationen feintunen und zum Beispiel Nachrichten im Nachhinein bearbeiten oder Teile der Unterhaltung wieder einfügen. Das ist ideal, wenn ihr tiefer in die Materie eintauchen wollt, ohne von zu vielen Optionen erschlagen zu werden. Das Zahnrad für die Power-User Einstellungen befindet sich mittig oben, links neben der Anzeige des geladenen Modells.

- Developer Für alle, die alles wollen! Dieser Modus schaltet wirklich alle Funktionen frei, inklusive spezieller Entwickler-Optionen und auch alle Tastaturkürzel. Hier könnt ihr jede einzelne Einstellung von LM Studio anpassen und die KI genau auf eure Bedürfnisse zuschneiden. Wenn ihr mit der API oder der Kommandozeile arbeitet, werdet ihr diesen Modus lieben.

Ihr könnt euren Modus ganz einfach unten in der App auswählen. Startet als User, und wenn ihr euch sicherer fühlt, wechselt einfach zum Power User oder Developer-Modus. So wächst LM Studio mit euren Fähigkeiten.

Mit Dokumenten chatten: RAG für eure lokalen Dateien

Ein absolutes Highlight von LM Studio ist die Fähigkeit, mit euren eigenen Dokumenten zu chatten – komplett offline! Ihr könnt einfach .docx-, .pdf– oder .txt-Dateien an eure Chatsitzung anhängen und der KI so zusätzlichen Kontext geben.

Wie funktioniert das?

- RAG (Retrieval-Augmented Generation): Wenn euer Dokument sehr lang ist, wendet LM Studio eine clevere Technik namens RAG an. Die App durchsucht eure Datei nach den relevantesten Informationen, die zu eurer Frage passen, und füttert nur diese „gefundenen“ Schnipsel an das LLM. Das ist wie ein persönlicher Bibliothekar, der nur die wichtigen Passagen für euch heraussucht.

- Voller Kontext: Wenn euer Dokument kurz genug ist (d. h. es passt in den „Arbeitsspeicher“ des Modells, auch Kontext genannt), fügt LM Studio einfach den gesamten Inhalt hinzu. Das funktioniert super bei neueren Modellen wie Llama 3.1 oder Mistral Nemo, die längere Kontexte unterstützen.

Tipp für erfolgreiches RAG: Je genauer eure Frage ist, desto besser. Wenn ihr nach Begriffen, Ideen oder bestimmten Wörtern fragt, die im Dokument vorkommen, erhöht ihr die Chance, dass das System genau die richtigen Informationen findet und an das Modell weitergibt.

Hilfreiche Tipps und Tricks

Modfizierung der Ausgabe

LM Studio hat eine besonders interessante Funktion für die nachträgliche Bearbeitung von Ausgaben eurer Prompts: Ihr könnt einfach den Output des LLM selbst mit der Bearbeiten-Funktion verändern. Die findet ihr unter der Ausgabe als ein Stiftsymbol. Änderungen die ihr dort einpflegt beeinflussen dann euren weiteren Chatverlauf, das LLM merkt sich sozusagen eure Bearbeitung als neuen Kontext für die weitere Konversation.

Sagen wir mal ihr wollt eine Übersicht für eins eurer Projekte erstellen, gebt euren Prompt ein aber die Ausgabe müsste nochmal überarbeitet werden weil Kennzahlen oder Informationen anders oder falsch eingepflegt wurden. Einfach editieren und das LLM arbeitet ab dann mit euren angepassten Informationen weiter.

Strukturierte Ausgaben

Manchmal reicht ein einfacher Text nicht aus. Wenn ihr wollt, dass eure KI nicht nur redet, sondern auch Daten in einem bestimmten Format ausspuckt, dann ist die strukturierte Ausgabe euer bester Freund. Ob JSON, YAML oder Markdown-Tabellen, ihr könnt die KI gezielt anweisen, sich an ein Format zu halten.

Das ist super nützlich, wenn ihr die KI-Ausgabe direkt in andere Systeme einspeisen wollt, wie zum Beispiel in einen Telegram-Bot, eine Datenbank oder eure Entwicklungsumgebung (IDE).

Ihr gebt eurem Modell die Anweisung einfach direkt im Prompt oder im System Prompt. Zum Beispiel:

Verhalte dich wie ein Finanz-Analyst. Deine Ausgabe soll in diesem JSON format erfolgen: {“empfehlung”: “string”, “grund”: “string”}

Die KI wird dann nicht mehr mit einem freien Text antworten, sondern mit einem perfekten JSON-Objekt, das genau euren Vorgaben entspricht.

Aber Achtung: Nicht jedes Modell ist gleich gut darin, sich an diese strikten Regeln zu halten. Die Fähigkeit, valides JSON oder andere Formate zu erstellen, hängt stark vom Modell ab. Also testet am besten ein paar Modelle, um das zu finden, das am zuverlässigsten strukturiert arbeitet.

LM Studio konfigurieren: Macht es zu eurem eigenen

LM Studio ist schon von Haus aus super, aber ihr könnt es an eure Bedürfnisse anpassen. Für die jenigen von Euch die keine Lust haben alles zu lesen, hab ich hier ein Video für euch:

Mehr Power im Chat: Branch & Ordner

Manchmal braucht man einfach einen Neuanfang, ohne den bisherigen Verlauf zu verlieren. Genau dafür gibt es „Branch“! Diese praktische Funktion, die ihr direkt unter dem Chat findet, erstellt eine Kopie eurer laufenden Konversation.

Das ist perfekt, wenn ihr zB. einen neuen Absatz für eure Präsentation geschrieben habt und jetzt aus diesem letzten Absatz einen Prompt für eine Bild-KI generieren wollt. Einfach auf „Branch“ klicken, den neuen Prompt erstellen und das Ergebnis in ein externes Bilderstellungs-Tool kopieren. So könnt ihr in der Zwischenzeit mit dem alten Chat-Verlauf weitermachen, ohne etwas zu überschreiben.

Apropos Chats: LM Studio speichert alle eure Konversationen in einem übersichtlichen Menü auf der linken Seite. Hier könnt ihr Ordner anlegen und eure Chats einfach per Drag-and-drop sortieren. So behaltet ihr auch bei vielen Projekten den Überblick.

Speicherpfad für eure Konversationen

Unter Mac / Linux findet ihr die hier:

~/.lmstudio/conversations/Unter Windows sind sie dort: (Verzeichnisse die mit einem . starten seht ihr standardmäßig nicht. Nutzt deshalb „Versteckte und Systemverzeichnisse anzeigen“)

%USERPROFILE%\.lmstudio\conversationsCommunity

Mit Augen und ohne Zensur: Vision-Modelle & „Abliterated“ LLMs

Ihr wollt nicht nur mit Text, sondern auch mit Bildern arbeiten? Kein Problem! LM Studio unterstützt Vision-Modelle, die visuelle Inhalte verarbeiten können. Sucht einfach nach Modellen mit einem gelben Augensymbol, wie z. B. Gemma 3 4B. Diesen Modellen könnt ihr im Chat Bilder anhängen und sie bitten, die Inhalte zu analysieren oder Prompts dafür zu generieren.

Wenn euch bei euren Geschichten oder Ideen die ethischen Filter der normalen KIs in die Quere kommen, gibt es auch eine Lösung: „Unzensierte“ Modelle. Diese LLMs wurden von der Community so modifiziert, dass sie weniger strenge Sicherheitsbarrieren haben. Ihr findet sie in der Modellsuchleiste oft mit dem Schlagwort „abliterated“. Aber seid gewarnt: Die Ersteller weisen darauf hin, dass diese Modelle sensible, kontroverse oder unangemessene Inhalte produzieren können. Also nutzt sie mit Bedacht!

Die geheime Schaltzentrale: Dein System Prompt in LM Studio

Jedes leistungsstarke Tool hat eine geheime Gebrauchsanweisung. Bei Large Language Models (LLMs) ist das der System Prompt. Das ist kein normaler Befehl, sondern eine übergeordnete Anweisung, die das gesamte Gespräch und die Persönlichkeit deiner KI festlegt. Wenn ein User-Prompt eine einzelne Frage ist, dann ist der System Prompt das „Jobprofil“, das die KI für die gesamte Sitzung definiert.

Warum ist das so wichtig? Für lokale Modelle, die kleiner und spezialisierter sind, ist der System Prompt der Schlüssel. Er gibt ihnen die nötige Richtung, um präzise und zuverlässig zu arbeiten. Du kannst damit die KI anweisen, einen bestimmten Charakter anzunehmen (z. B. einen Piraten), sich nur auf ein Thema zu konzentrieren oder sogar ihre Gedankenschritte laut auszusprechen. Genau das ermöglicht es kleineren Modellen, die größeren nachzuahmen und erstaunliche Ergebnisse zu erzielen.

System Prompt vs. User Prompt: Die Unterscheidung ist entscheidend

Oft werden Begriffe wie „Prompt“ und „Preset“ durcheinandergebracht. Aber die Unterscheidung ist einfach und super wichtig:

- Der System Prompt legt die Regeln und die Persönlichkeit für die ganze Konversation fest. Er ist statisch und bleibt bestehen.

- Der User Prompt ist die spezifische Frage oder Aufgabe, die du der KI in jeder einzelnen Runde stellst. Er ist dynamisch und ändert sich ständig.

Dieses System sorgt dafür, dass die KI ihre Rolle nicht vergisst und konsistente Antworten liefert.

So nutzt du den System Prompt in LM Studio

LM Studio macht es dir leicht, diese Power zu nutzen. Oben rechts im Eck ist ein unscheinbarer Schraubenschlüssel. Ein Klick darauf bringt dich zu den Content, Model und Prompt Voreinstellungen. Im Content-Panel findest du ein spezielles Feld, in das du den System Prompt eingeben kannst. Das ist deine Kommandozentrale.

Schritt-für-Schritt-Anleitung: Dein erster eigener System Prompt

- Modell laden: Geh zum Entdecken-Tab (Lupensymbol) und lade ein Modell wie Mistral 7B Instruct herunter. Wechsle dann zum Chat-Tab und lade es dort.

- System Prompt eingeben: Oben rechts auf den Schraubenschlüssel im Eck gibst du deine Anweisung ein, zum Beispiel: „You are a helpful assistant who always responds in the style of a haiku.“ oder „Verhalte dich wie ein Bestseller-Autor der einen Roman redigiert“

- Frage stellen: Tippe eine einfache Frage ins untere Eingabefeld, z. B.: „What is a large language model?„

- Ergebnis sehen: Die Antwort der KI wird nicht mehr normal sein, sondern ein Gedicht im Haiku-Stil. So siehst du sofort, wie viel Einfluss der System Prompt hat!

Presets: Dein Werkzeugkasten für perfekte Prompts

Jedes Mal einen komplizierten System Prompt einzutippen, ist mühsam. Deshalb gibt es Presets! Ein Preset ist eine .preset.json-Datei, die nicht nur deinen System Prompt, sondern auch alle anderen Einstellungen wie Temperatur oder Kontextlänge speichert.

Wenn du eine Konfiguration perfektioniert hast, klicke einfach auf „Save Preset“. Gib dem Preset einen Namen (z. B. „Shakespearean Poet“) und du kannst es jederzeit mit einem Klick wieder laden. Das spart jede Menge Zeit und macht die Arbeit mit der KI reproduzierbar.

Profi-Tipp: Prompt und Modell müssen zusammenpassen!

Die meisten modernen LLMs sind auf ein bestimmtes Format trainiert. Wenn du den falschen System Prompt verwendest, kann es zu unsinnigen Antworten kommen. Die „Gebrauchsanweisung“ für jedes Modell findet ihr auf seiner Hugging Face Model Card. Dort steht genau, wie der System Prompt aussehen muss.

Ein bekanntes Beispiel ist die DeepSeek Coder-Modellreihe. Diese Modelle erwarten einen ganz bestimmten System Prompt. Wenn du ihn nicht verwendest, kann es sein, dass die KI nicht auf deine Programmierfragen antwortet, weil sie sich ohne diese Anleitung unsicher ist. Das zeigt, wie eng die Qualität der KI mit dem richtigen System Prompt zusammenhängt.

Häufige Fragen (FAQ)

- Wofür brauche ich den System Prompt? Er legt die Regeln und die Persönlichkeit für die gesamte Konversation fest, damit die KI konsistent bleibt und genau das tut, was du von ihr erwartest.

- Kann ich einen System Prompt für alle Modelle verwenden? Nein. Während allgemeine Prompts oft funktionieren, benötigen spezialisierte Modelle wie DeepSeek Coder einen ganz bestimmten Prompt. Schau am besten immer erst auf der HuggingFace Seite des Modells nach!

- Mein System Prompt funktioniert nicht! Was tun? Überprüfe, ob das Prompt-Format zum Modell passt. Ein weiterer häufiger Fehler sind die Inference Parameters im rechten Panel. Wenn Prompt Eval Batch Size (n_batch) viel kleiner als Context Length (n_ctx) ist, kann die KI ihre eigenen Anweisungen „vergessen“. Versuche, beide Werte anzupassen, um die besten Ergebnisse zu erzielen.

Für Power-User: Die LM Studio Kommandozeile (CLI)

Ihr liebt es, Dinge zu automatisieren und direkt im Terminal zu arbeiten? Dann ist die lms-Kommandozeile genau das Richtige für euch. lms ist das CLI-Tool, das mit LM Studio mitgeliefert wird und es euch ermöglicht, eure Workflows zu scripten und zu automatisieren. So könnt ihr eure lokalen LLMs direkt vom Terminal aus steuern.

Wichtig: Bevor ihr lms nutzen könnt, müsst ihr LM Studio mindestens einmal gestartet haben.

Die Einrichtung ist kinderleicht:

- lms bootstappen: Öffnet euer Terminal (oder PowerShell unter Windows) und gebt folgenden Befehl ein

macOS/Linux:

~/.lmstudio/bin/lms bootstrapWindows:

cmd /c %USERPROFILE%/.lmstudio/bin/lms.exe bootstrapInstallation überprüfen: Startet ein neues Terminal-Fenster und gebt einfach lms ein. Ihr solltet eine Liste der verfügbaren Befehle sehen.

Die wichtigsten Befehle auf einen Blick:

Mit diesen Befehlen könnt ihr die grundlegenden Funktionen von LM Studio direkt im Terminal ausführen:

- Server steuern: Startet oder stoppt den lokalen Server, um eure Modelle per API zu nutzen.

lms server startlms server stop

- Modelle auflisten: Zeigt alle Modelle an, die ihr auf eurem Rechner habt, oder die, die gerade geladen sind.

lms ls(listet alle heruntergeladenen Modelle)lms ps(listet die aktuell geladenen Modelle auf)

- Modelle laden und entladen: Lädt ein Modell in den Arbeitsspeicher oder entfernt es wieder.

Ihr könnt sogar Parameter wie die GPU-Auslastung (--gpu=1.0) und die Kontextlänge (--context-length=16384) direkt mitgeben.

lms load TheBloke/phi-2-GGUFlms unload --all(entlädt alle geladenen Modelle)

Die lms CLI ist ein mächtiges Werkzeug für alle, die tiefer in die Welt der lokalen LLMs eintauchen möchten. Probiert es aus und automatisiert eure KI-Projekte!

Die API: Dein lokaler OpenAI-Klon

Ihr wollt eure lokalen Modelle nicht nur im Chat nutzen, sondern direkt in eigene Apps und Projekte einbinden? LM Studio macht’s möglich. Die App stellt eine OpenAI-kompatible API bereit, die sich wie der echte Dienst anfühlt, nur dass alles lokal auf eurem Rechner läuft.

So einfach verbindet ihr euch

Das Geniale daran: Ihr müsst eure bestehenden Skripte oder Clients für OpenAI kaum anpassen. Ändert einfach die Base URL eurer API-Anfragen so, dass sie auf euren lokalen LM Studio-Server verweisen (http://localhost:1234/v1). Euer Code glaubt, er kommuniziert mit OpenAI, aber in Wirklichkeit bleibt alles auf eurem Computer.

Hier sind ein paar Beispiele, wie das in verschiedenen Sprachen aussieht:

Python

from openai import OpenAI

client = OpenAI(

base_url="http://localhost:1234/v1"

)

# ... der Rest deines Codes bleibt gleich ...

TypeScript

import OpenAI from 'openai';

const client = new OpenAI({

baseUrl: "http://localhost:1234/v1"

});

// ... der Rest deines Codes bleibt gleich ...

Typische Sprachen für die API-Anbindung

Neben Python und TypeScript (JavaScript) werden vor allem diese Sprachen häufig für die API-Anbindung verwendet, da sie eigene Bibliotheken für die Interaktion mit APIs mitbringen:

- Java: Mit HTTP-Clients wie

OkHttpoderApacheHttpClientlassen sich REST-Anfragen problemlos an die API von LM Studio senden. Es gibt auch spezielle OpenAI-Client-Bibliotheken für Java, die ihr anpassen könnt. - Go: Die Standardbibliothek von Go (

net/http) ist perfekt, um HTTP-Anfragen zu stellen. Es ist eine schlanke und effiziente Wahl für Backend-Anwendungen. - C#: Für .NET-Entwickler bietet die Sprache mit dem

HttpClientdie idealen Werkzeuge, um sich mit der API zu verbinden. Auch hier gibt es spezielle Pakete, die die Anbindung an OpenAI-kompatible Dienste erleichtern. - PHP: In der Webentwicklung kommt PHP oft zum Einsatz. Ihr könnt die

cURL-Erweiterung oder Bibliotheken wieGuzzlenutzen, um API-Anfragen zu senden. - Ruby: Mit Bibliotheken wie

faradayoder der integriertennet/httpBibliothek lässt sich die API von LM Studio ansteuern. - Rust: Wer Wert auf Geschwindigkeit und Sicherheit legt, nutzt Rust. Bibliotheken wie

reqwestmachen API-Anfragen einfach und sicher.

Das Schöne an der OpenAI-Kompatibilität ist, dass ihr nicht auf eine bestimmte Sprache beschränkt seid. Solange ihr die Basis-URL anpassen könnt, steht euch die Welt der Programmierung offen, um mit euren lokalen LLMs zu interagieren.

Die wichtigsten API-Endpunkte

LM Studio unterstützt die gängigsten OpenAI-Endpunkte, sodass ihr nahtlos arbeiten könnt:

GET /v1/models: Listet alle Modelle auf, die gerade in LM Studio geladen sind. Perfekt, um eure Projekte dynamisch zu gestalten.POST /v1/chat/completions: Das ist der Haupt-Endpunkt für den Chat. Ihr könnt eure Konversationen als Chat-Verlauf übergeben und erhaltet eine Antwort von der KI. Hier werden die System-Prompts und alle Parameter (wietemperature) automatisch angewendet.POST /v1/embeddings: Ideal, um Text in Vektoren umzuwandeln. Das ist besonders nützlich für RAG (Retrieval-Augmented Generation), also das Chatten mit euren Dokumenten.POST /v1/completions: Auch wenn OpenAI diesen Endpunkt nicht mehr aktiv unterstützt, könnt ihr ihn in LM Studio nutzen, um die Fortsetzung eines Textes zu generieren. Beachtet hierbei, dass Chat-Modelle unter Umständen unerwartetes Verhalten zeigen. Für dieses Feature eignen sich „Base Models“ am besten.

Mit der API von LM Studio seid ihr nicht auf die grafische Oberfläche beschränkt, sondern könnt die volle Power eurer lokalen KI direkt in eure eigenen Tools integrieren und das mit der vertrauten OpenAI-Syntax.

Fazit: Dein KI-Abenteuer beginnt jetzt!

Seht ihr? Ihr seid jetzt quasi fast schon LM Studio-Experten! Vom Download eures ersten Modells bis zum Plaudern mit Llama habt ihr die Kraft der lokalen KI entfesselt. LM Studio ist perfekt für Anfänger, weil es keinerlei Programmierkenntnisse erfordert, eure Daten schützt und euch Zugang zu einer riesigen Auswahl an Modellen gibt. Schritt für Schritt bietet es euch aber auch wirklich tolle erweiterte Funktionen und Optionen.

Was ist euer erstes Projekt? Ein Chatbot? Ein Gedichtgenerator? Oder vielleicht wollt ihr die KI bitten, bei den Hausaufgaben zu helfen? Egal wie, viel Spaß!

Quellen: LM Studio Masterclass | HuggingFace | Heise Ratgeber KI | LMStudio Docs | LMStudio Community | LMS Discord | LMS Github | @lmstudio