Ehi ragazzi, avete mai sognato di avere il vostro piccolo ChatGPT sul computer, dove i vostri dati appartengono davvero solo a voi?

Poi mettiti le cinture di sicurezza, perché LM Studio (Stand 25.9 nella versione 0.3.27) è qui per realizzare questo sogno per Linux, Mac e Windows! Questa fantastica app desktop semplifica l'esecuzione di modelli di lingua di grandi dimensioni (LLM) come Llama, Phi o Gemma localmente sul tuo computer. Nessun abbonamento cloud, nessun furto di dati, solo pura potenza AI che controlli tu stesso. E per tutti coloro che finora hanno fatto un grande arco attorno a Huggingface e alla riga di comando direttamente tutto chiaro: Ha una GUI chiara e facile da capire.

Ti guiderò attraverso la configurazione e ti mostrerò come scatenare la tua magia AI in pochissimo tempo. Che tu stia scrivendo, codificando o semplicemente curioso, LM Studio È un vero e proprio game changer. Iniziamo e lasciamo che alcune scintille AI volino!

Che cos'è LM Studio? La tua avventura AI locale

Alzati in piedi LM Studio come il tuo hub di intelligenza artificiale personale. È un'app che funziona su Windows, Mac e Linux ed esegue LLM open source direttamente da Abbracciare la faccia Mettilo sul tuo computer. Puoi navigare, scaricare e chattare con i modelli senza la necessità di una connessione Internet o di costosi servizi cloud.

LM Studio fa tutto il lavoro tecnico per voi. Carica i modelli in memoria e fornisce un'interfaccia intuitiva che ricorda ChatGPT. Quindi puoi concentrarti completamente sul fare domande o creare cose interessanti. La cosa migliore? I tuoi dati non lasciano mai il tuo computer.

Installare LM Studio: Più facile di uno scaffale IKEA

L'installazione di LM Studio E' davvero un gioco da ragazzi. Lo prometto!

- Controllo dell'hardware:

Il tuo computer ha bisogno di un po 'di potenza, ma non preoccuparti, non deve essere un supercomputer.

- RAM: Almeno 16 GB è l'ideale per la maggior parte dei modelli (8 GB sono sufficienti per i modelli più piccoli).

- memoria: I modelli sono da 2 a 20 GB di dimensioni. Fai spazio sul tuo disco rigido.

- CPU/GPU: Una CPU moderna è sufficiente, ma una GPU (NVIDIA/AMD) rende tutto più veloce. Gli utenti Mac con chip M1/M2/M3 hanno un chiaro vantaggio qui, poiché la loro GPU integrata funziona estremamente bene. GPU NVIDIA più recenti con supporto CUDA (RTX up).

- RAM: Almeno 16 GB è l'ideale per la maggior parte dei modelli (8 GB sono sufficienti per i modelli più piccoli).

- Scarica l' installazione di &:

- Si alza lmstudio.ai e scaricare il programma di installazione per il sistema operativo. Eseguilo e segui le istruzioni. Si tratta di una classica configurazione "Next, Next, Done". Inizia LM Studio. Atterrerai sulla home page con una barra di ricerca e una selezione di modelli. Se non si vede il pulsante "Salta" grigio poco appariscente, un primo modello verrà caricato direttamente sullo sfondo.

Questo era tutto! Per me ci sono voluti meno di cinque minuti.

Utilizzo di LM Studio: Scoprire e chattare modelli

Ora, dove LM Studio Correre, il divertimento può iniziare!

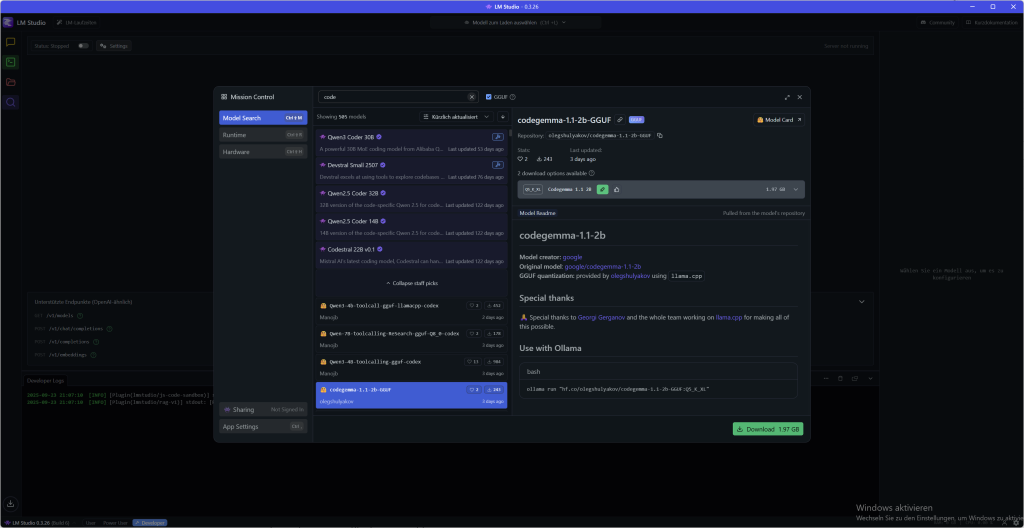

- Selezionare e scaricare il modello:

- Fare clic sull'icona della lente di ingrandimento ("Scopri") nella barra laterale sinistra. Questo è il tuo negozio di caramelle modello.

- Cerca un modello che ti interessa, come ad esempio: Llama 3.1 8B oppure Mistral-7B-Instruct.

- Per i principianti, consiglio un modello quantizzato (ad esempio una versione Q4_K_M) da 4 a 8 GB. Sono veloci ed efficienti.

- Basta cliccare su "Download" accanto al modello. L'avanzamento viene visualizzato nella scheda Download.

- Fare clic sull'icona della lente di ingrandimento ("Scopri") nella barra laterale sinistra. Questo è il tuo negozio di caramelle modello.

- Caricamento e chat:

- Una volta completato il download, vai all'icona della cartella ("I miei modelli").

- Fare clic sul modello scaricato e quindi fare clic su "Carica". Il modello è ora caricato in memoria.

- Passare all'icona a forma di bolla vocale ("Chat") e selezionare il modello caricato dal menu a discesa.

- Ora puoi iniziare! Chiedi all'IA di scherzare, chiedi loro di scrivere una poesia o lascia che ti spieghino un concetto complesso.

- Una volta completato il download, vai all'icona della cartella ("I miei modelli").

La chat sembra esattamente come un servizio online, ma l'intera conversazione si svolge offline. Le tue parole rimangono private e non c'è limite e nessun costo aggiuntivo per un abbonamento.

Scarica LLM: Scopri e seleziona i modelli

LM Studio ha un proprio downloader di modelli che funziona direttamente con Abbracciare la faccia collegato. Ecco come trovare il modello perfetto per te:

- Cerca e trova: Vai alla scheda "Scopri" (lente di ingrandimento) o semplicemente premi ?? + 2 (Mac) e Ctrl + 2 (Windows/Linux). È possibile effettuare una ricerca per parole chiave quali "llama", "gemma" o "lmstudio". Puoi anche aggiungere URL completi di Hugging Face alla barra di ricerca!

- Qualità vs. dimensione: Per ogni modello, ci sono spesso diverse opzioni di download che sembrano criptiche, come Q3_K_S oppure Q_8. Questo Q sta per quantizzazione, Una tecnica che comprime i modelli. Di conseguenza, diventano più piccoli e funzionano più velocemente, ma perdono un po 'di qualità. Per cominciare, scegli un'opzione a 4 bit o superiore che offra un buon compromesso. I dettagli possono essere trovati qui in questo articolo Leggilo.

Basta selezionare il modello desiderato e cliccare su "Scarica". L'avanzamento viene visualizzato nella scheda Download. A proposito, se la posizione predefinita non si adatta, puoi modificare la posizione dei tuoi modelli nella scheda I miei modelli.

L'interfaccia: Dal principiante all'utente professionale

LM Studio Non è solo uno strumento, si adatta a te. Sia che tu stia appena iniziando o che tu sia già una vera e propria crepa AI, l'interfaccia utente offre tre diverse modalità nel piè di pagina in basso a sinistra, che puoi facilmente cambiare. Quindi hai sempre solo le funzioni in vista di cui hai davvero bisogno.

Le modalità a colpo d'occhio:

- Utente Questa modalità è perfetta per tutti principiante. Mostra solo l'interfaccia della chat e configura automaticamente tutto in background. Non devi preoccuparti di nulla qui e puoi iniziare subito. Basta caricare il modello e chattare, non è più facile.

- Utente di potenza Se vuoi più controllo, questa è la tua modalità. Qui hai accesso a tutti Parametri di carico e di inferenza e funzioni avanzate di chat. È possibile perfezionare le conversazioni e, ad esempio, modificare i messaggi in seguito o reinserire parti della conversazione. Questo è l'ideale se vuoi approfondire la questione senza essere ucciso da troppe opzioni. L'ingranaggio per le impostazioni dell'utente di alimentazione si trova al centro della parte superiore, a sinistra del display del modello caricato.

- sviluppatore Per chi vuole tutto! Questa modalità gira davvero tutte le funzioni gratuito, comprese le opzioni speciali per sviluppatori e tutte le scorciatoie da tastiera. Qui puoi trovare ogni singola impostazione di LM Studio adattare e adattare l'IA esattamente alle tue esigenze. Se lavori con l'API o la riga di comando, amerai questa modalità.

Puoi facilmente selezionare la modalità nella parte inferiore dell'app. Inizia come Utente, E quando ti senti più sicuro, basta passare al Utente di potenza oppure sviluppatoreModalità di funzionamento. Ecco come cresce LM Studio con le tue capacità.

Chatta con i documenti: RAG per i file locali

Un punto culminante assoluto di LM Studio è la possibilità di chattare con i propri documenti, completamente offline! Puoi semplicemente .docx-, .pdf– oppure .txtAllega i file alla tua sessione di chat e fornisci all'IA un contesto extra.

Come funziona?

- RAG (Recupero-generazione aumentata): Se il documento è molto lungo, applicare LM Studio È una tecnica intelligente chiamata RAG. L'app cerca nel tuo file le informazioni più pertinenti che si adattano alla tua domanda e fornisce solo questi frammenti "trovati" all'LLM. Questo è come un bibliotecario personale che sceglie solo i passaggi importanti per te.

- Contesto completo: Se il documento è sufficientemente breve (ossia rientra nella "memoria" del modello, anche contesto chiamato), aggiunge LM Studio Basta aggiungere tutti i contenuti. Questo funziona alla grande con i modelli più recenti come Llama 3.1 oppure Mistral Nemo, che supportano contesti più lunghi.

Suggerimento per RAG di successo: Più accurata è la tua domanda, meglio è. Quando si chiedono termini, idee o parole specifiche che appaiono nel documento, si aumenta la possibilità che il sistema trovi esattamente le informazioni giuste e le trasmetta al modello.

Consigli e trucchi utili

Modifica dell'output

LM Studio ha una funzione particolarmente interessante per la successiva elaborazione dei problemi delle vostre richieste: È possibile modificare facilmente l'output del LLM stesso con la funzione Modifica. Puoi trovarlo sotto l'output come simbolo della penna. Le modifiche che inserisci influenzeranno l'ulteriore cronologia della chat, LLM ricorda la modifica come nuovo contesto per l'ulteriore conversazione.

Supponiamo che tu voglia creare una panoramica per uno dei tuoi progetti, inserisci il prompt ma l'output dovrebbe essere rivisto di nuovo perché le cifre chiave o le informazioni sono state inserite in modo diverso o errato. Basta modificare e il LLM continuerà a lavorare con le tue informazioni personalizzate.

Spese strutturate

A volte un semplice testo non basta. Se vuoi che la tua intelligenza artificiale non solo parli, ma anche sputi i dati in un certo formato, allora il Edizione strutturata Il tuo migliore amico. Se JSON, YAML oppure Tabelle di Markdown, Puoi specificamente istruire l'IA ad attenersi a un formato.

Questo è super utile se si desidera alimentare l'output AI direttamente in altri sistemi, come un bot Telegram, un database o il proprio ambiente di sviluppo (IDE).

È sufficiente dare al modello le istruzioni direttamente nel Prompt o nel sistema Prompt. Ad esempio:

Agisci come un analista finanziario. Il tuo output dovrebbe essere in questo formato JSON: {"Raccomandazione": "stringa", "terreno": "stringa"}

L'IA non risponderà più con un testo libero, ma con un oggetto JSON perfetto che corrisponde esattamente alle tue specifiche.

Ma attenzione: Non tutti i modelli sono ugualmente bravi a rispettare queste rigide regole. L'abilità, JSON valido o per creare altri formati dipende fortemente dal modello. Quindi è meglio testare alcuni modelli per trovare quello che funziona in modo più affidabile strutturato.

Configurare LM Studio: Rendilo tuo

LM Studio È fantastico, ma puoi adattarlo alle tue esigenze. Per quelli di voi che non vogliono leggere tutto, ecco un video per voi:

Più potenza nella chat: Branch & Cartella

A volte hai solo bisogno di un nuovo inizio senza perdere il corso precedente. Esattamente per questo ci sono "Succursale"! Questa comoda funzione, che si trova proprio sotto la chat, crea una copia della conversazione in corso.

Questo è perfetto, ad esempio, se hai scritto un nuovo paragrafo per la tua presentazione e ora vuoi generare un prompt per un'immagine AI da quest'ultimo paragrafo. Basta cliccare su «Branch», creare il nuovo prompt e copiare il risultato in uno strumento esterno per la creazione di immagini. Nel frattempo, puoi continuare con la vecchia cronologia delle chat senza sovrascrivere nulla.

A proposito di chat: LM Studio Salva tutte le tue conversazioni in un menu chiaro a sinistra. Qui puoi creare cartelle e ordinare le tue chat semplicemente trascinando e rilasciando. Quindi tieni traccia anche di molti progetti.

Percorso di archiviazione per le tue conversazioni

Su Mac/Linux potete trovarli qui:

~/.lmstudio/conversazioni/Su Windows, ci sono: (Direzioni che iniziano con un . non si vede per impostazione predefinita. Utilizza quindi "Mostra directory nascoste e di sistema")

%PROFILO DELL'UTENTE%\.lmstudio\conversazioniComunità

Con gli occhi e senza censura: Modelli di visione & LLM "Abliterated"

Vuoi lavorare non solo con il testo, ma anche con le immagini? Nessun problema! LM Studio supportato Modelli di visione, che può elaborare contenuti visivi. Basta cercare modelli con un simbolo di occhio giallo, come ad esempio: Gemma 3 4B. È possibile allegare immagini a questi modelli nella chat e chiedere loro di analizzare il contenuto o generare richieste per esso.

Se le tue storie o idee ostacolano i filtri etici delle normali IA, c'è anche una soluzione: Modelli "non censurati". Questi LLM sono stati modificati dalla comunità per avere barriere di sicurezza meno rigorose. Puoi trovarli spesso nella barra di ricerca del modello con la parola chiave Abliterato. Ma siate avvertiti: I creatori sottolineano che questi modelli possono produrre contenuti sensibili, controversi o inappropriati. Quindi usatelo saggiamente!

Il centro di controllo segreto: Il tuo System Prompt in LM Studio

Ogni potente strumento ha istruzioni segrete per l'uso. Modelli di grandi lingue (LLM) Sistema rapido. Questo non è un comando normale, ma un'istruzione prevalente che determina l'intera conversazione e personalità della tua IA. Se il prompt di un utente è un'unica domanda, il sistema Prompt è il "profilo di lavoro" che definisce l'IA per l'intera sessione.

Perché è così importante? Per i modelli locali più piccoli e specializzati, il sistema Prompt è fondamentale. Dà loro la direzione di cui hanno bisogno per lavorare in modo accurato e affidabile. Puoi usarlo per istruire l'IA ad adottare un personaggio specifico (come un pirata), concentrarti solo su un argomento o persino pronunciare i loro passi di pensiero ad alta voce. Questo è esattamente ciò che rende possibile per i modelli più piccoli imitare quelli più grandi e ottenere risultati sorprendenti.

Prompt del sistema vs. Prompt dell'utente: La distinzione è cruciale

Termini come "prompt" e "preset" sono spesso confusi. Ma la distinzione è semplice e super importante:

- Il prompt di sistema pone il Regole e personalità per tutta la conversazione. È statico e persiste.

- Il prompt dell'utente è il Domanda o compito specifico, che metti all'IA in ogni singolo round. È dinamico e in continua evoluzione.

Questo sistema garantisce che l'IA non dimentichi il suo ruolo e fornisce risposte coerenti.

Come utilizzare il sistema Prompt in LM Studio

LM Studio semplifica l'utilizzo di questa potenza. Nell'angolo in alto a destra c'è una chiave poco appariscente. Fare clic su di esso ti porterà alle preferenze Contenuto, Modello e Prompt. Nel pannello dei contenuti troverai un campo speciale in cui puoi inserire il prompt di sistema. Questo è il tuo centro di comando.

Istruzioni dettagliate: Il tuo primo sistema Prompt

- Modello di carico: Vai alla scheda Discover (Lupensymbol) e carica un modello come Mistral 7B Istruire giù. Quindi passare alla scheda chat e caricarlo lì.

- Inserisci il System Prompt: In alto a destra della chiave inglese nell'angolo, inserisci le tue istruzioni, ad esempio: "Sei un assistente utile che risponde sempre nello stile di un haiku."o "Comportarsi come un autore di best-seller che pubblica un romanzo"

- Fai una domanda: Digitare una semplice domanda nel campo di input sottostante, ad esempio: "Che cos'è un modello linguistico di grandi dimensioni?„

- Vedi il risultato: La risposta dell'IA non sarà più normale, ma una poesia in stile haiku. Quindi puoi immediatamente vedere quanta influenza ha il sistema Prompt!

Preimpostazioni: La tua cassetta degli attrezzi per suggerimenti perfetti

Digitare in un sistema complicato Prompt ogni volta è noioso. Ecco perché ci sono preimpostazioni! Un preset è un .preset.jsonFile che salva non solo il prompt del sistema, ma anche tutte le altre impostazioni come la temperatura o la lunghezza del contesto.

Una volta che hai perfezionato una configurazione, fai clic su "Salva preimpostato". Dare un nome al preset (ad esempio "Shakespearean Poet") e ricaricarlo in qualsiasi momento con un clic. Ciò consente di risparmiare molto tempo e rende riproducibile il lavoro con l'IA.

Consiglio professionale: Prompt e modello devono stare insieme!

La maggior parte degli LLM moderni sono addestrati in un determinato formato. Se si utilizza il sistema sbagliato Prompt, può portare a risposte insensate. Le "istruzioni per l'uso" di ciascun modello sono riportate sul relativo Abbracciare la carta del modello del viso. Mostra esattamente come dovrebbe essere il sistema.

Un esempio ben noto è il DeepSeek CoderSerie di modelli. Questi modelli si aspettano un prompt di sistema molto specifico. Se non lo usi, l'IA potrebbe non rispondere alle tue domande di programmazione perché non è sicura senza questa guida. Ciò dimostra quanto strettamente la qualità dell'IA sia correlata al giusto sistema Prompt.

Domande frequenti (FAQ)

- Perché ho bisogno del sistema Prompt? Stabilisce le regole e la personalità per l'intera conversazione in modo che l'IA rimanga coerente e faccia esattamente ciò che ti aspetti che faccia.

- Posso utilizzare un prompt di sistema per tutti i modelli? No. Mentre i suggerimenti generali spesso funzionano, modelli specializzati come DeepSeek Coder Un prompt molto specifico. Controlla sempre prima la pagina HuggingFace del modello!

- Il mio sistema Prompt non funziona! Cosa fare? Controllare se il formato del prompt corrisponde al modello. Un altro errore comune è il Parametri di inferenza nel pannello di destra. Se: Dimensione rapida del lotto di Eval (n_batch) molto più piccolo di Lunghezza del contesto (n_ctx) L'IA può "dimenticare" le proprie istruzioni. Prova a regolare entrambi i valori per ottenere i migliori risultati.

Per gli utilizzatori di energia elettrica: La riga di comando di LM Studio (CLI)

Ti piace automatizzare le cose e lavorare direttamente nel terminale? Allora è lmsLinea di comando giusta per te. lms è lo strumento CLI che funziona con LM Studio Ti consente di creare script e automatizzare i tuoi flussi di lavoro. Ciò consente di controllare i LLM locali direttamente dal terminale.

Importante: Prima di te lms Puoi usarlo, devi LM Studio Iniziato almeno una volta.

La struttura è un gioco da ragazzi:

- lms bootstappen: Aprire il terminale (o PowerShell su Windows) e digitare il seguente comando

macOS/Linux:

~/.lmstudio/bin/lms bootstrapfinestre:

cmd /c %PROFILO DELL'UTENTE%/.lmstudio/bin/lms.exe bootstrapVerificare l'installazione: Inizia nuovo Finestra terminale e basta dare lms uno. Dovresti vedere un elenco di comandi disponibili.

I comandi più importanti a colpo d'occhio:

Con questi comandi, è possibile utilizzare le funzioni di base di LM Studio Eseguire direttamente nel terminale:

- Controllare il server: Avviare o interrompere il server locale per utilizzare i modelli tramite API.

Avvio del server lmslms server stop

- Modelli dell'elenco: Visualizza tutti i modelli che hai sul tuo computer o quelli che sono attualmente caricati.

lms ls(Elenca tutti i modelli scaricati)lms ps(elenca i modelli attualmente caricati)

- Modelli di carico e scarico: Carica un modello in memoria o lo rimuove.

È anche possibile impostare parametri come l'utilizzo della GPU (--gpu=1.0) e la lunghezza del contesto (--context-length=16384) direttamente.

Caricamento di lms TheBloke/phi-2-GGUFlms scaricare --tutti(scarica tutti i modelli caricati)

Il lms CLI è un potente strumento per chiunque voglia approfondire il mondo degli LLM locali. Provalo e automatizza i tuoi progetti AI!

L'API: Il tuo clone OpenAI locale

Non vuoi solo utilizzare i tuoi modelli locali in chat, ma anche integrarli direttamente nelle tue app e progetti? LM Studio lo rende possibile. L'app fornisce un API compatibile con OpenAI Ready, che sembra il vero servizio, solo che tutto viene eseguito localmente sul tuo computer.

È così facile da connettere

La cosa geniale a riguardo: Non è necessario personalizzare gli script o i client esistenti per OpenAI. Basta cambiarli URL di base le tue richieste API in modo che puntino al tuo server LM Studio locale (http://localhost:1234/v1). Il tuo codice pensa di comunicare con OpenAI, ma in realtà tutto rimane sul tuo computer.

Ecco alcuni esempi di come appare in diverse lingue:

pitone

da openai import OpenAI client = OpenAI( base_url="http://localhost:1234/v1" ) # Il resto del tuo codice rimane lo stesso.

TypeScript

importare OpenAI da "openai"; const client = nuovo OpenAI({ baseUrl: "http://localhost:1234/v1" }); // ... il resto del tuo codice rimane lo stesso ...

Lingue tipiche per la connessione API

Oltre a pitone e TypeScript (JavaScript) in particolare questi linguaggi sono spesso utilizzati per la connessione API perché hanno le proprie librerie per interagire con le API:

- Java: Con client HTTP come

OkHttpoppureApacheHttpClientLe richieste REST possono essere facilmente inviate all'API di LM Studio. Ci sono anche speciali librerie client OpenAI per Java che è possibile personalizzare. - Vai: La libreria standard di Go (

rete/http) è perfetto per effettuare richieste HTTP. È una scelta snella ed efficiente per le applicazioni di back-end. - C#: Per gli sviluppatori .NET, il linguaggio con

HttpClientgli strumenti ideali per connettersi all'API. Anche qui ci sono pacchetti speciali che rendono più facile la connessione ai servizi compatibili con OpenAI. - PHP: PHP è spesso utilizzato nello sviluppo web. Puoi usarli

cURLEstensioni o librerie comeGuzzleUsalo per inviare richieste API. - rubino: Biblioteche come

faradayo l'integratorete/httpLa libreria può essere utilizzata per controllare l'API di LM Studio. - ruggine: Se si valuta la velocità e la sicurezza, utilizzare Rust. Biblioteche come

reqwestrendere le richieste API semplici e sicure.

La bellezza del Compatibilità con OpenAI Non sei limitato a una lingua specifica. Finché puoi personalizzare l'URL di base, il mondo della programmazione è aperto a te per interagire con i tuoi LLM locali.

Gli endpoint API principali

LM Studio Supporta gli endpoint OpenAI più comuni in modo da poter lavorare senza problemi:

GET /v1/modelli: Elenca tutti i modelli attualmente caricati in LM Studio. Perfetto per rendere dinamici i tuoi progetti.POST /v1/chat/completamenti: Questo è l'endpoint principale per la chat. Puoi passare le tue conversazioni come cronologia chat e ottenere una risposta dall'IA. Qui il sistema richiede e tutti i parametri (come ad esempiotemperatura) applicato automaticamente.POST /v1/incorporazioni: Ideale per convertire il testo in vettori. Questo è particolarmente utile per RAG (Retrieval-Augmented Generation), cioè chattare con i tuoi documenti.POST /v1/completamenti: Anche se OpenAI non supporta più attivamente questo endpoint, è possibile utilizzarlo in LM Studio utilizzare per generare la continuazione di un testo. Si noti che i modelli di chat possono mostrare comportamenti imprevisti. I modelli di base sono più adatti per questa funzione.

Con l'API di LM Studio Non sei limitato all'interfaccia grafica, ma puoi integrare tutta la potenza della tua AI locale direttamente nei tuoi strumenti con la familiare sintassi OpenAI.

Conclusione: La tua avventura AI inizia ora!

Vedi? Sei quasi già LM StudioEsperti! Dal download del tuo primo modello alla chat con Llama, hai scatenato la potenza dell'IA locale. LM Studio È perfetto per i principianti perché non richiede alcuna abilità di programmazione, protegge i tuoi dati e ti dà accesso a una vasta gamma di modelli. Passo dopo passo, ti offre anche funzionalità e opzioni avanzate davvero fantastiche.

Qual è il tuo primo progetto? Un chatbot? Un generatore di poesie? O forse vuoi chiedere all'IA di aiutarti con i compiti? Non importa cosa, buon divertimento!

Fonti: Masterclass di LM Studio | HuggingFace | Guida calda AI | LMStudio Docs | Comunità di LMStudio | LMS Discord | LMS Github | @lmstudio