Hey les gars, avez-vous déjà rêvé d'avoir votre propre petit chatGPT sur l'ordinateur, où vos données sont vraiment à vous?

Alors attachez-vous, car LM Studio (Stand 25.9 dans la version 0.3.27) est ici pour réaliser ce rêve pour Linux, Mac et Windows! Cette application de bureau super cool facilite l'exécution locale de modèles de langage large (LLM) tels que Llama, Phi ou Gemma sur votre ordinateur. Pas d'abonnement au cloud, pas de vol de données, juste de la pure puissance d'IA que vous contrôlez vous-même. Et pour tous ceux qui ont fait un grand arc jusqu'à présent autour de Huggingface et de la ligne de commande, désalerte directe: Il a une interface graphique claire et facile à comprendre.

Je vais vous guider à travers l'installation et vous montrer comment libérer votre propre magie de l'IA en un clin d'œil. Que vous écriviez, codez ou soyez simplement curieux, LM Studio C'est un vrai Game Changer. Allons-y et laissons voler quelques étincelles d'IA!

Qu'est-ce que LM Studio? Votre aventure IA locale

Imaginez-vous LM Studio comme votre hub personnel d'IA. C'est une application qui s'exécute sur Windows, Mac et Linux et qui gère les LLM open source directement à partir de Hugging Face Apportez-le sur votre ordinateur. Vous pouvez parcourir, télécharger et discuter avec des modèles sans connexion Internet ni services cloud coûteux.

LM Studio s'occupe de tout le travail technique. Il charge les modèles en mémoire et fournit une interface intuitive qui rappelle ChatGPT. Ainsi, vous pouvez vous concentrer pleinement sur la pose de questions ou la création de choses cool. Le meilleur de tout ça? Vos données ne quittent jamais votre ordinateur.

Installer LM Studio: Plus simple qu'une étagère IKEA

L'installation de LM Studio C'est vraiment un jeu d'enfant. Promis!

- Vérification du matériel:

Votre ordinateur a besoin d'un peu de puissance, mais ne vous inquiétez pas, il n'a pas besoin d'être un supercalculateur.

- RAM: Au moins 16 Go sont idéaux pour la plupart des modèles (8 Go suffisent pour les plus petits).

- mémoire: Les modèles mesurent de 2 à 20 Go. Faites de la place sur votre disque dur.

- CPU/GPU: Un CPU moderne suffit, mais un GPU (NVIDIA/AMD) rend tout plus rapide. Les utilisateurs de Mac avec des puces M1/M2/M3 sont clairement avantagés ici, car leur GPU intégré fonctionne extrêmement bien. Nouveaux GPU NVIDIA avec prise en charge CUDA (RTX vers le haut) ainsi.

- RAM: Au moins 16 Go sont idéaux pour la plupart des modèles (8 Go suffisent pour les plus petits).

- Télécharger & Installation:

- Se lève lmstudio.ai et téléchargez le programme d'installation de votre système d'exploitation. Exécutez-le et suivez les instructions. Il s’agit d’une configuration classique «Suivant, Suivant, Terminé». Commence LM Studio. Vous atterrissez sur la page d'accueil avec une barre de recherche et une sélection de modèles. Si vous ne voyez pas le bouton gris discret «Skip», un premier modèle est même chargé directement en arrière-plan.

C'est tout! Pour moi, tout cela m'a pris moins de cinq minutes.

Utilisation de LM Studio: Découvrir et discuter des modèles

Maintenant, où LM Studio En cours d'exécution, le plaisir peut commencer!

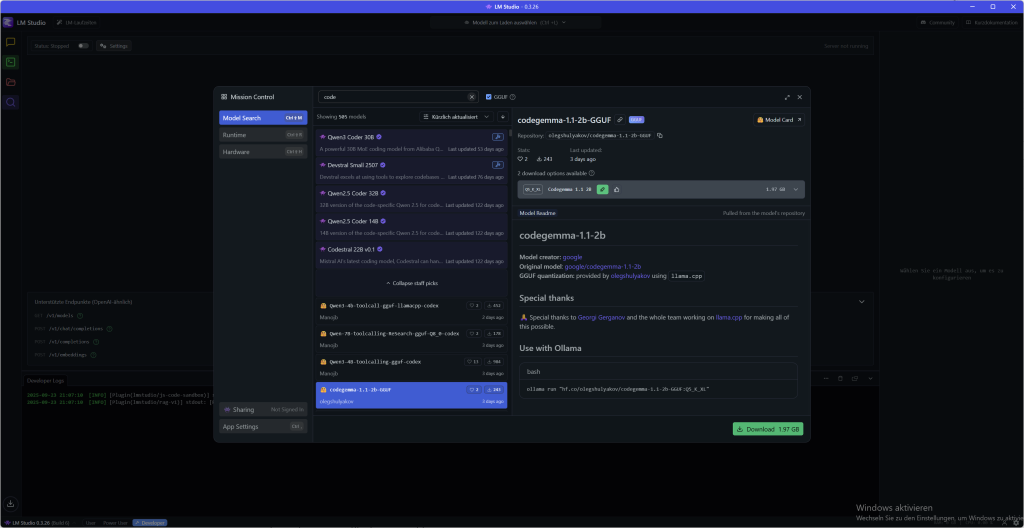

- Sélectionner et télécharger le modèle:

- Cliquez sur l’icône «Découvrir» dans la barre latérale gauche. C'est votre magasin de bonbons modèle.

- Recherchez un modèle qui vous intéresse, comme Llama 3.1 8B ou Instructeur Mistral-7B.

- Pour les débutants, je recommande un modèle quantifié (par exemple, une version Q4_K_M) de 4 à 8 Go. Ils sont rapides et efficaces.

- Cliquez simplement sur «Télécharger» à côté du modèle. La progression s’affiche dans l’onglet «Téléchargements».

- Cliquez sur l’icône «Découvrir» dans la barre latérale gauche. C'est votre magasin de bonbons modèle.

- Chargement et chat:

- Une fois le téléchargement terminé, accédez à l’icône du dossier («Mes modèles»).

- Cliquez sur le modèle téléchargé, puis sur «Télécharger». Le modèle est maintenant chargé en mémoire.

- Accédez à l’icône de la bulle de conversation («Chat») et sélectionnez votre modèle chargé dans le menu déroulant.

- Maintenant, vous pouvez commencer! Demandez à l'IA une blague, demandez-lui d'écrire un poème ou demandez-lui de vous expliquer un concept complexe.

- Une fois le téléchargement terminé, accédez à l’icône du dossier («Mes modèles»).

Le chat est exactement comme un service en ligne, mais toute la conversation se déroule hors ligne. Vos mots restent privés et il n'y a pas de limite ni de frais supplémentaires pour un abonnement.

Télécharger les LLM: Découvrir et sélectionner des modèles

LM Studio a son propre téléchargeur de modèle qui fonctionne directement avec Hugging Face connectés. Voici comment trouver le modèle parfait pour vous:

- Rechercher et trouver: Accédez à l’onglet «Découvrir» (la loupe) ou appuyez simplement sur ⁇ + 2 (Mac) ou Ctrl + 2 (Windows/Linux). Vous pouvez rechercher des mots-clés tels que «llama», «gemma» ou «lmstudio». Vous pouvez même insérer des URL Hugging Face complètes dans la barre de recherche!

- Qualité vs. taille: Pour chaque modèle, il existe souvent plusieurs options de téléchargement qui semblent cryptiques, telles que Q3_K_S ou Q_8. Le Q représente: quantification, Une technique qui compresse les modèles. En conséquence, ils deviennent plus petits et courent plus vite, mais perdent un peu de qualité. Pour commencer, choisissez une option 4 bits ou plus, qui offrent un bon compromis. Pour plus de détails, vous pouvez dans cet article lire.

Il vous suffit de sélectionner le modèle souhaité et de cliquer sur «Télécharger». La progression s’affiche dans l’onglet «Téléchargements». Par ailleurs, vous pouvez modifier l’emplacement de vos modèles dans l’onglet «Mes modèles» si l’emplacement par défaut ne convient pas.

L'interface: Du débutant à l'utilisateur professionnel

LM Studio Ce n'est pas seulement un outil, il s'adapte à vous. Que vous débutiez ou que vous soyez déjà un véritable crack d'IA, l'interface utilisateur propose trois modes différents dans le pied de page en bas à gauche, que vous pouvez facilement basculer. Ainsi, vous n'avez toujours à l'esprit que les fonctions dont vous avez vraiment besoin.

Les modes en un coup d'œil:

- user Ce mode est parfait pour tout le monde débutant. Il affiche uniquement l'interface de chat et configure automatiquement tout en arrière-plan. Ici, vous n'avez pas à vous soucier de quoi que ce soit et vous pouvez commencer immédiatement. Il suffit de charger le modèle et de discuter, ce n’est pas plus facile.

- Power User Si vous voulez plus de contrôle, c'est votre mode. Ici, vous avez accès à tous Paramètres de chargement et d'inférence ainsi que des fonctionnalités de chat avancées. Vous pouvez peaufiner vos conversations et, par exemple, éditer des messages rétrospectivement ou réinsérer des parties de la conversation. C'est idéal si vous voulez plonger plus profondément dans la matière sans être écrasé par trop d'options. L'engrenage pour les réglages Power User se trouve au centre en haut à gauche de l'affichage du modèle chargé.

- Developer Pour tous ceux qui veulent tout! Ce mode commute vraiment toutes les fonctions gratuit, y compris les options spéciales pour les développeurs et tous les raccourcis clavier. Ici, vous pouvez voir toutes les attitudes de LM Studio adapter et adapter l'IA à vos besoins. Si vous utilisez l'API ou la ligne de commande, vous allez adorer ce mode.

Vous pouvez facilement sélectionner votre mode en bas de l'application. Commence comme user, et si vous vous sentez plus en sécurité, il suffit de passer à Power User ou Developermode. C'est ainsi que grandit LM Studio avec vos capacités.

Discuter avec des documents: RAG pour vos fichiers locaux

Un point culminant absolu de LM Studio est la possibilité de discuter avec vos propres documents – complètement hors ligne! Vous pouvez simplement .docx-, .pdf– ou .txt-Ajouter des fichiers à votre session de chat pour ajouter du contexte à l'IA.

Comment ça marche?

- RAG (Retrieval-Augmented Generation): Si votre document est très long, tournez LM Studio Il s'agit d'une technique intelligente appelée RAG. L’application recherche dans votre fichier les informations les plus pertinentes qui correspondent à votre question et ne fait qu’alimenter le LLM de ces extraits «trouvés». C'est comme un bibliothécaire personnel qui ne choisit que les passages importants pour vous.

- Plein contexte: Si votre document est suffisamment court (c’est-à-dire qu’il s’insère dans la «mémoire vive» du modèle, y compris: contexte appelé), ajoute LM Studio Il suffit d'ajouter tout le contenu. Cela fonctionne très bien avec les nouveaux modèles comme Llama 3.1 ou Mistral Nemo, qui soutiennent des contextes plus longs.

Astuce pour un RAG réussi: Plus votre question est précise, mieux c'est. Lorsque vous demandez des termes, des idées ou des mots spécifiques qui apparaissent dans le document, vous augmentez les chances que le système trouve exactement les bonnes informations et les transmette au modèle.

Trucs et astuces utiles

Modification de la sortie

LM Studio dispose d'une fonctionnalité particulièrement intéressante pour le traitement ultérieur des sorties de vos invites: Vous pouvez simplement modifier la sortie du LLM lui-même à l'aide de la fonction d'édition. Vous pouvez le trouver sous la sortie comme un symbole de stylo. Les changements que vous y introduisez influenceront ensuite votre historique de discussion, le LLM se souviendra de votre modification comme d'un nouveau contexte pour la conversation ultérieure.

Disons que vous voulez créer une vue d'ensemble pour l'un de vos projets, entrez votre requête, mais la sortie devrait être révisée à nouveau parce que les indicateurs ou les informations ont été saisies différemment ou incorrectement. Il suffit d'éditer et le LLM continuera à travailler avec vos informations personnalisées.

Dépenses structurées

Parfois, un simple texte ne suffit pas. Si vous voulez que votre IA ne se contente pas de parler, mais crache également des données dans un certain format, alors le Édition structurée Votre meilleur ami. Qu'il s'agisse JSON, YAML ou Tableaux de Markdown, Vous pouvez demander à l'IA de s'en tenir à un format.

C'est très utile si vous souhaitez intégrer la sortie IA directement dans d'autres systèmes, tels qu'un bot Telegram, une base de données ou votre environnement de développement (IDE).

Vous donnez simplement l'instruction à votre modèle directement dans l'invite ou l'invite système. Par exemple:

Agissez comme un analyste financier. Votre sortie doit se faire dans ce format JSON: {"recommandation": «string», «raison»: "string"}

L'IA ne répondra plus avec un texte libre, mais avec un objet JSON parfait qui correspond exactement à vos spécifications.

Mais attention: Tous les modèles ne sont pas aussi bons pour respecter ces règles strictes. La capacité, JSON valide ou créer d'autres formats dépend fortement du modèle. Il est donc préférable de tester quelques modèles pour trouver celui qui fonctionne de la manière la plus fiable et structurée.

Configurer LM Studio: Faites-en votre propre

LM Studio C'est génial, mais vous pouvez l'adapter à vos besoins. Pour ceux d'entre vous qui n'ont pas envie de tout lire, voici une vidéo pour vous:

Plus de puissance dans le chat: Branch & Dossier

Parfois, vous avez juste besoin d'un nouveau départ sans perdre le cours précédent. C'est précisément pour cela qu'il existe «Branch»! Cette fonctionnalité pratique, que vous trouverez directement sous le chat, créera une copie de votre conversation en cours.

C'est parfait si, par exemple, vous avez écrit un nouveau paragraphe pour votre présentation et que vous voulez maintenant générer une invite pour une IA d'image à partir de ce dernier paragraphe. Il suffit de cliquer sur «Branch», de créer la nouvelle invite et de copier le résultat dans un outil de création d’images externe. Pendant ce temps, vous pouvez continuer avec l'ancien historique de chat sans rien écraser.

En parlant de chats: LM Studio Enregistrez toutes vos conversations dans un menu clair à gauche. Ici, vous pouvez créer des dossiers et trier vos chats simplement par glisser-déposer. Ainsi, vous gardez une vue d'ensemble sur de nombreux projets.

Chemin de stockage pour vos conversations

Sous Mac / Linux, vous pouvez les trouver ici:

~/.lmstudio/conversations/Sous Windows, ils sont là: (Vous ne voyez pas les répertoires commençant par un . par défaut. Utilise donc «Afficher les répertoires cachés et système»)

%PROFIL DE L'UTILISATEUR%\.lmstudio\conversationsCommunauté

Avec les yeux et sans censure: Modèles de vision & LLM «Abliterated»

Vous voulez travailler non seulement avec du texte, mais aussi avec des images? Pas de problème! LM Studio soutenu Modèles de vision, qui peuvent traiter des contenus visuels. Il suffit de rechercher des modèles avec un symbole d'œil jaune, tels que: Gemma 3 4B. Vous pouvez joindre des images à ces modèles dans le chat et leur demander d'analyser le contenu ou de générer des invites pour cela.

Si les filtres éthiques des IA normales s'opposent à vos histoires ou à vos idées, il existe également une solution: Modèles «non censurés». Ces LLM ont été modifiés par la communauté pour avoir des barrières de sécurité moins strictes. Vous les trouverez souvent dans la barre de recherche de modèles avec le mot-clé «abliterated». Mais soyez prévenus: Les créateurs soulignent que ces modèles peuvent produire du contenu sensible, controversé ou inapproprié. Alors utilisez-les judicieusement!

Le centre de contrôle secret: Votre système Invite dans LM Studio

Chaque outil puissant a un mode d'emploi secret. Les LLM (Large Language Models) sont System Prompt. Ce n'est pas une commande normale, mais une instruction générale qui définit toute la conversation et la personnalité de votre IA. Si une invite utilisateur est une question unique, l’invite système est le «profil d’emploi» qui définit l’IA pour l’ensemble de la session.

Pourquoi est-ce si important? Pour les modèles locaux plus petits et plus spécialisés, le système Prompt est la clé. Il leur donne la direction nécessaire pour travailler avec précision et fiabilité. Vous pouvez l’utiliser pour demander à l’IA d’adopter un personnage spécifique (par exemple, un pirate), de se concentrer uniquement sur un sujet ou même de prononcer à haute voix ses pas de pensée. C'est ce qui permet aux modèles plus petits d'imiter les plus grands et d'obtenir des résultats étonnants.

System Prompt vs User Prompt: La distinction est cruciale

Les termes «prompt» et «preset» sont souvent confondus. Mais la distinction est simple et super importante:

- Le système Prompt pose les Les règles et la personnalité pour toute la conversation. Il est statique et persiste.

- L'utilisateur Prompt est la Question ou tâche spécifique, que vous présentez à l'IA à chaque tour. Il est dynamique et change constamment.

Ce système garantit que l'IA n'oublie pas son rôle et fournit des réponses cohérentes.

Comment utiliser System Prompt dans LM Studio

LM Studio vous permet d'utiliser facilement cette puissance. En haut à droite dans le coin est une clé discrète. Cliquez dessus pour accéder aux préréglages Content, Model et Prompt. Dans le panneau de contenu, vous trouverez un champ spécial dans lequel vous pouvez entrer l'invite système. C'est ton centre de commandement.

Guide étape par étape: Votre premier système Prompt

- Chargement du modèle: Accédez à l'onglet Découvrir (icône de loupe) et chargez un modèle comme Mistral 7B Instruct vers le bas. Ensuite, passez à l'onglet Chat et chargez-le là.

- Saisissez System Prompt: En haut à droite de la clé dans le coin, entrez vos instructions, par exemple: «You are a helpful assistant who always responds in the style of a haiku.« ou «Comportez-vous comme un auteur de best-sellers qui édite un roman»

- Poser une question: Tapez une question simple dans le champ de saisie inférieur, par exemple: «Qu'est-ce qu'un modèle de langue large?„

- Voir le résultat: La réponse de l'IA ne sera plus normale, mais un poème de style haïku. De cette façon, vous pouvez voir immédiatement l'impact du système Prompt!

Préréglages: Votre boîte à outils Pour des prompts parfaits

Saisir une invite système compliquée à chaque fois est fastidieux. C'est pourquoi il y a Presets! Un preset est une .preset.json-Fichier qui enregistre non seulement l'invite de votre système, mais aussi tous les autres paramètres tels que la température ou la longueur du contexte.

Une fois que vous avez perfectionné une configuration, cliquez simplement sur Préréglage de sauvegarde. Donnez un nom au préréglage (par exemple, «Shakespearean Poet») et vous pouvez le recharger à tout moment en un seul clic. Cela permet d'économiser beaucoup de temps et rend le travail avec l'IA reproductible.

Conseil de pro: Rapide et modèle doivent correspondre!

La plupart des LLM modernes sont formés à un format spécifique. Si vous utilisez le mauvais système d'invite, il peut y avoir des réponses insensées. Le « mode d’emploi » de chaque modèle figure sur son Carte modèle Hugging Face. C'est exactement à quoi doit ressembler le système Prompt.

Un exemple connu est celui Codeur DeepSeekSérie de modèles. Ces modèles s'attendent à une vitesse de système très spécifique. Si vous ne l'utilisez pas, il se peut que l'IA ne réponde pas à vos questions de programmation, car elle n'est pas sûre sans ce guide. Cela montre à quel point la qualité de l'IA est étroitement liée au bon système d'accélération.

Questions fréquentes (FAQ)

- Pourquoi ai-je besoin du System Prompt? Il définit les règles et la personnalité de toute la conversation afin que l'IA reste cohérente et fasse exactement ce que vous attendez d'elle.

- Puis-je utiliser un System Prompt sur tous les modèles? Non, non. Bien que les invites générales fonctionnent souvent, les modèles spécialisés tels que Codeur DeepSeek Un rythme très précis. Jetez toujours un coup d'œil sur le côté HuggingFace du modèle!

- Mon système Prompt ne fonctionne pas! Que faire? Vérifiez que le format d'invite correspond au modèle. Une autre erreur fréquente est la Paramètres d'inférence dans le panneau de droite. Lorsque: Prompt Eval Batch Size (n_batch) beaucoup plus petit que Context Length (n_ctx) l’IA peut «oublier» ses propres instructions. Essayez d'ajuster les deux valeurs pour obtenir les meilleurs résultats.

Pour les power users: La ligne de commande LM Studio (CLI)

Vous aimez automatiser les choses et travailler directement dans le terminal? Ensuite, c'est lmsLa ligne de commande est faite pour vous. lms C'est l'outil CLI qui LM Studio Il vous permet de scripter et d'automatiser vos workflows. Ainsi, vous pouvez contrôler vos LLM locales directement à partir du terminal.

Important: Avant que vous lms Si vous pouvez l'utiliser, vous devez LM Studio ont démarré au moins une fois.

L'installation est un jeu d'enfant:

- bootstappen de lms: Ouvrez votre terminal (ou PowerShell sous Windows) et tapez la commande suivante

macOS/Linux:

~/.lmstudio/bin/lms bootstrapWindows:

cmd /c %PROFIL DE L'UTILISATEUR%/.lmstudio/bin/lms.exe bootstrapVérifier l'installation: Démarre nouveau Fenêtre de terminal et entrez simplement lms un. Vous devriez voir une liste des commandes disponibles.

Les principales commandes en un coup d'œil:

Avec ces commandes, vous pouvez utiliser les fonctions de base de LM Studio Exécuter directement dans le terminal:

- Contrôler le serveur: Lancez ou arrêtez le serveur local pour utiliser vos modèles via l'API.

Démarrer le serveur lmslms server stop

- Liste des modèles: Affiche tous les modèles que vous avez sur votre ordinateur ou ceux qui sont en cours de chargement.

lms ls(liste de tous les modèles téléchargés)lms ps(répertorie les modèles actuellement chargés)

- Chargement et déchargement des modèles: Charge ou supprime un modèle en mémoire.

Vous pouvez même utiliser des paramètres tels que l'utilisation du GPU (--gpu=1.0) et la longueur du contexte (--context-length=16384) directement.

lms load TheBloke/phi-2-GGUFlms unload --all(décharge tous les modèles chargés)

Les lms CLI est un outil puissant pour tous ceux qui veulent plonger plus profondément dans le monde des LLM locaux. Essayez-le et automatisez vos projets d'IA!

L'API: Votre clone OpenAI local

Vous ne voulez pas seulement utiliser vos modèles locaux dans le chat, mais les intégrer directement dans vos propres applications et projets? LM Studio rend cela possible. L'app présente une API compatible OpenAI prêt à se sentir comme le vrai service, sauf que tout fonctionne localement sur votre ordinateur.

C'est aussi simple que ça que vous vous connectez

Ce qu'il y a de génial: Vous n'avez pas besoin de personnaliser vos scripts ou clients existants pour OpenAI. Il suffit de changer les URL de base vos requêtes API de manière à ce qu'elles pointent vers votre serveur local LM Studio (http://localhost:1234/v1). Votre code croit qu'il communique avec OpenAI, mais en réalité, tout reste sur votre ordinateur.

Voici quelques exemples de ce à quoi cela ressemble dans différentes langues:

Python

from openai import OpenAI client = OpenAI( base_url="http://localhost:1234/v1" ) # Le reste de votre code reste le même...

TypeScript

import OpenAI from 'openai'; const client = new OpenAI({ baseUrl: "http://localhost:1234/v1" }); // ... le reste de votre code reste le même ...

Langues typiques pour la connexion API

En plus de Python et TypeScript (JavaScript), en particulier, ces langages sont couramment utilisés pour la connexion aux API, car ils ont leurs propres bibliothèques pour interagir avec les API:

- Java: Avec des clients HTTP tels que

OkHttpouApacheHttpClientLes requêtes REST peuvent être facilement envoyées à l'API de LM Studio. Il existe également des bibliothèques clientes OpenAI spéciales pour Java que vous pouvez personnaliser. - Go: La bibliothèque standard de Go (

net/http) est parfait pour faire des requêtes HTTP. C'est un choix élégant et efficace pour les applications backend. - C#: Pour les développeurs .NET, la langue avec le

HttpClientles outils idéaux pour se connecter à l'API. Encore une fois, il existe des packages spéciaux qui facilitent la connexion aux services compatibles OpenAI. - PHP: PHP est souvent utilisé dans le développement web. Vous pouvez les

cURL-Extension ou bibliothèques telles queGuzzleutiliser pour envoyer des demandes d'API. - Ruby: Avec des bibliothèques comme

faradayou l'Intégrénet/httpLa bibliothèque peut être contrôlée par l'API de LM Studio. - Rust: Ceux qui attachent de l'importance à la vitesse et à la sécurité utilisent Rust. Les bibliothèques comme

reqwestrendre les demandes d'API simples et sécurisées.

Ce qu'il y a de beau dans le Compatibilité OpenAI Vous n'êtes pas limité à une langue en particulier. Tant que vous pouvez personnaliser l'URL de base, le monde de la programmation est ouvert pour interagir avec vos LLM locaux.

Principaux points de terminaison API

LM Studio prend en charge les points de terminaison OpenAI les plus courants afin que vous puissiez travailler en toute transparence:

GET /v1/models: Répertorie tous les modèles actuellement chargés dans LM Studio. Parfait pour rendre vos projets dynamiques.POST /v1/chat/completions: C'est le point de terminaison principal pour le chat. Vous pouvez passer vos conversations en tant qu'historique de chat et recevoir une réponse de l'IA. Ici, les invites système et tous les paramètres (tels quetemperature) appliqué automatiquement.POST /v1/embeddings: Idéal pour convertir du texte en vecteurs. Ceci est particulièrement utile pour RAG (Retrieval-Augmented Generation), c'est-à-dire pour discuter avec vos documents.POST /v1/completions: Bien qu'OpenAI ne supporte plus activement ce point de terminaison, vous pouvez LM Studio pour générer la suite d'un texte. Notez que les modèles de chat peuvent avoir un comportement inattendu. Les modèles de base sont les mieux adaptés à cette fonctionnalité.

Avec l'API de LM Studio Vous n'êtes pas limité à l'interface graphique, mais vous pouvez intégrer toute la puissance de votre IA locale directement dans vos propres outils avec la syntaxe OpenAI familière.

Conclusion: Votre aventure IA commence maintenant!

Vous voyez? Vous êtes presque déjà LM StudioDes experts! Du téléchargement de votre premier modèle au bavardage avec Llama, vous avez déchaîné la puissance de l'IA locale. LM Studio Il est parfait pour les débutants car il ne nécessite aucune connaissance en programmation, protège vos données et vous donne accès à une vaste gamme de modèles. Pas à pas, il vous offre également de très bonnes fonctionnalités et options avancées.

Quel est votre premier projet? Un chatbot? Un générateur de poèmes? Ou peut-être voulez-vous demander à l'IA de vous aider à faire vos devoirs? Peu importe comment, amusez-vous!

Sources : LM Studio Masterclass | HuggingFace | Heise Guide de l'IA | LMStudio Docs | Communauté LMStudio | LMS Discord | LMS Github | @lmstudio