¿Alguna vez soñaste con tener tu propio ChatGPT en la computadora, donde tus datos realmente te pertenecen solo a ti?

Entonces ponte los cinturones de seguridad, porque LM Studio (Stand 25.9 en la versión 0.3.27) está aquí para hacer realidad este sueño para Linux, Mac y Windows! Esta aplicación de escritorio súper genial hace que sea fácil ejecutar grandes modelos de lenguaje (LLM) como Llama, Phi o Gemma localmente en su computadora. Sin suscripción a la nube, sin robo de datos, solo poder de IA puro que te controlas a ti mismo. Y para todos aquellos que hasta ahora han hecho un gran arco alrededor de Huggingface y la línea de comandos directamente claro: Tiene una interfaz gráfica de usuario clara y fácil de entender.

Te guiaré a través de la configuración y te mostraré cómo liberar tu propia magia de IA en muy poco tiempo. Ya sea que estés escribiendo, codificando o simplemente curioso, LM Studio Él es un verdadero cambiador de juego. ¡Empecemos y dejemos volar algunas chispas de IA!

¿Qué es LM Studio? Tu aventura local de IA

Levántate LM Studio como tu centro personal de IA. Es una aplicación que se ejecuta en Windows, Mac y Linux y ejecuta LLM de código abierto directamente desde Cara de abrazo Ponlo en tu computadora. Puede navegar, descargar y chatear con modelos sin la necesidad de una conexión a Internet o costosos servicios en la nube.

LM Studio hace todo el trabajo técnico por usted. Carga los modelos en la memoria y proporciona una interfaz intuitiva que recuerda a ChatGPT. Así que puedes concentrarte completamente en hacer preguntas o crear cosas geniales. ¿Lo mejor de todo? Tus datos nunca salen de tu ordenador.

Instalar LM Studio: Más fácil que un estante de IKEA

La instalación de LM Studio Realmente es una obviedad. ¡Lo prometo!

- Comprobación de hardware:

Su computadora necesita algo de energía, pero no se preocupe, no tiene que ser una supercomputadora.

- RAM: Al menos 16 GB es ideal para la mayoría de los modelos (8 GB es suficiente para los modelos más pequeños).

- memoria: Los modelos son de 2 a 20 GB de tamaño. Haz espacio en tu disco duro.

- CPU/GPU: Una CPU moderna es suficiente, pero una GPU (NVIDIA/AMD) hace que todo sea más rápido. Los usuarios de Mac con chips M1/M2/M3 tienen una clara ventaja aquí, ya que su GPU integrada funciona extremadamente bien. Nuevas GPU NVIDIA con soporte CUDA (RTX up) también.

- RAM: Al menos 16 GB es ideal para la mayoría de los modelos (8 GB es suficiente para los modelos más pequeños).

- Descargar & Instalación:

- Sube lmstudio.ai y descargue el instalador para su sistema operativo. Ejecútalo y sigue las instrucciones. Se trata de una configuración clásica «Next, Next, Done». Comienza LM Studio. Aterrizará en la página de inicio con una barra de búsqueda y una selección de modelos. Si no ve el botón gris discreto «Skip», se cargará un primer modelo directamente en el fondo.

¡Eso fue todo! Para mí, me tomó menos de cinco minutos.

Usando LM Studio: Descubrir y chatear modelos

Ahora, donde LM Studio Correr, la diversión puede comenzar!

- Seleccione y descargue el modelo:

- Haga clic en el icono de la lupa («Descubrir») en la barra lateral izquierda. Esta es tu tienda de dulces modelo.

- Busca un modelo que te interese, como: Llama 3.1 8B o Mistral-7B-Instrucciones.

- Para los principiantes, recomiendo un modelo cuantizado (por ejemplo, una versión Q4_K_M) con 4 a 8 GB. Son rápidos y eficientes.

- Simplemente haga clic en "Descargar" al lado del modelo. El progreso se muestra en la pestaña Descargas.

- Haga clic en el icono de la lupa («Descubrir») en la barra lateral izquierda. Esta es tu tienda de dulces modelo.

- Cargando y Chateando:

- Una vez completada la descarga, vaya al icono de la carpeta («Mis modelos»).

- Haga clic en el modelo descargado y luego haga clic en "Cargar". El modelo ahora está cargado en la memoria.

- Cambie al icono de burbuja de voz («Chat») y seleccione el modelo cargado en el menú desplegable.

- ¡Ahora puedes empezar! Pídele a la IA una broma, pídele que escriba un poema o deja que te explique un concepto complejo.

- Una vez completada la descarga, vaya al icono de la carpeta («Mis modelos»).

El chat se siente exactamente como un servicio en línea, pero toda la conversación tiene lugar fuera de línea. Sus palabras permanecen privadas y no hay límite ni costo adicional para una suscripción.

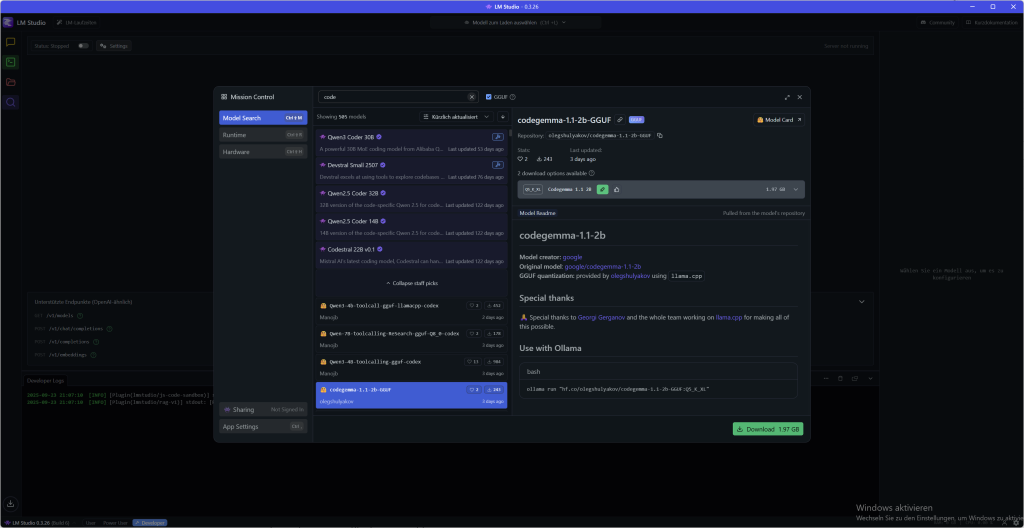

Descargar LLMs: Descubre y selecciona modelos

LM Studio tiene su propio descargador de modelos que funciona directamente con Cara de abrazo conectados. Aquí te mostramos cómo encontrar el modelo perfecto para ti:

- Buscar y encontrar: Vaya a la pestaña «Descubrir» (la lupa) o simplemente presione ?? + 2 (Mac) y Ctrl + 2 (Windows/Linux). Puede buscar por palabras clave como «llama», «gemma» o «lmstudio». ¡Incluso puedes agregar URL completas de Hugging Face a la barra de búsqueda!

- Calidad vs. tamaño: Para cada modelo, a menudo hay varias opciones de descarga que suenan crípticas, como Q3_K_S o Q_8. Esto Q significa cuantización, Una técnica que comprime modelos. Como resultado, se vuelven más pequeños y corren más rápido, pero pierden un poco de calidad. Para empezar, elija una opción de 4 bits o superior que ofrezca un buen compromiso. Los detalles se pueden encontrar aquí en este artículo Léelo.

Simplemente seleccione el modelo deseado y haga clic en «Descargar». El progreso se muestra en la pestaña Descargas. Por cierto, si la ubicación predeterminada no se ajusta, puede cambiar la ubicación de sus modelos en la pestaña Mis modelos.

La interfaz: De principiante a usuario profesional

LM Studio No es solo una herramienta, se adapta a ti. Ya sea que esté comenzando o ya sea una verdadera grieta de IA, la interfaz de usuario ofrece tres modos diferentes en el pie de página en la parte inferior izquierda, que puede cambiar fácilmente. Por lo tanto, siempre tiene solo las funciones a la vista que realmente necesita.

Los modos de un vistazo:

- Usuario Este modo es perfecto para todos principiante. Solo muestra la interfaz de chat y configura automáticamente todo en segundo plano. No tiene que preocuparse por nada aquí y puede comenzar de inmediato. Simplemente cargue el modelo y chatee, no es más fácil.

- Usuario avanzado Si quieres más control, este es tu modo. Aquí tienes acceso a todos Parámetros de carga e inferencia y funciones avanzadas de chat. Puede ajustar sus conversaciones y, por ejemplo, editar mensajes después o reinsertar partes de la conversación. Esto es ideal si desea profundizar en el asunto sin ser asesinado por demasiadas opciones. El engranaje para la configuración del usuario de energía se encuentra en el centro de la parte superior, a la izquierda de la pantalla del modelo cargado.

- desarrollador ¡Para los que lo quieren todo! Este modo realmente gira todas las funciones gratis, incluyendo opciones especiales para desarrolladores y todos los atajos de teclado. Aquí puede encontrar todos los ajustes de LM Studio adaptar y adaptar la IA exactamente a sus necesidades. Si trabajas con la API o la línea de comandos, te encantará este modo.

Puede seleccionar fácilmente su modo en la parte inferior de la aplicación. Comienza como Usuario, Y cuando te sientas más seguro, simplemente cambia al Usuario avanzado o desarrolladorModo de funcionamiento. Así es como crece LM Studio con tus habilidades.

Chatear con documentos: RAG para sus archivos locales

Un punto culminante absoluto de LM Studio es la posibilidad de chatear con sus propios documentos, ¡completamente fuera de línea! Usted puede simplemente .docx-, .pdf– o .txtAdjunta archivos a tu sesión de chat y dale a la IA un contexto adicional.

¿Cómo funciona?

- RAG (Generación de Recuperación-Aumentada): Si su documento es muy largo, aplique LM Studio Es una técnica inteligente llamada RAG. La aplicación busca en su archivo la información más relevante que se ajuste a su pregunta y solo envía estos fragmentos «encontrados» al LLM. Esto es como un bibliotecario personal que solo elige los pasajes importantes para usted.

- Contexto completo: Si su documento es lo suficientemente corto (es decir, encaja en la «memoria» del modelo, también contexto llamado), añade LM Studio Solo tienes que añadir todo el contenido. Esto funciona muy bien con modelos más nuevos como Llama 3.1 o Mistral Nemo, que admiten contextos más largos.

Consejo para un RAG exitoso: Cuanto más precisa sea tu pregunta, mejor. Cuando solicita términos, ideas o palabras específicas que aparecen en el documento, aumenta la posibilidad de que el sistema encuentre exactamente la información correcta y la transmita al modelo.

Consejos y trucos útiles

Modificación de la producción

LM Studio tiene una función particularmente interesante para el procesamiento posterior de los problemas de sus mensajes: Puede cambiar fácilmente la salida del LLM con la función Editar. Puedes encontrarlo debajo de la salida como un símbolo de bolígrafo. Los cambios que ingrese allí afectarán su historial de chat adicional, el LLM recuerda su edición como un nuevo contexto para la conversación posterior.

Digamos que desea crear una descripción general para uno de sus proyectos, ingrese su solicitud, pero la salida tendría que revisarse nuevamente porque las cifras clave o la información se ingresaron de manera diferente o incorrecta. Simplemente edite y el LLM continuará trabajando con su información personalizada.

Gastos estructurados

A veces un simple texto no es suficiente. Si desea que su IA no solo hable, sino que también escupa datos en un formato determinado, entonces el Edición estructurada Tu mejor amigo. Si JSON, YAML o Tablas de Markdown, Puede instruir específicamente a la IA para que se adhiera a un formato.

Esto es muy útil si desea alimentar la salida de IA directamente a otros sistemas, como un bot de Telegram, una base de datos o su entorno de desarrollo (IDE).

Simplemente le da a su modelo las instrucciones directamente en el sistema Prompt o en el sistema Prompt. Por ejemplo:

Actúa como un analista financiero. Su salida debe estar en este formato JSON: {“Recomendación”: “cadena”, “tierra”: "cadena"}

La IA ya no responderá con un texto libre, sino con un objeto JSON perfecto que coincida exactamente con sus especificaciones.

Pero cuidado: No todos los modelos son igualmente buenos para adherirse a estas estrictas reglas. La capacidad, Válido JSON o crear otros formatos depende en gran medida del modelo. Por lo tanto, es mejor probar algunos modelos para encontrar el que funcione de manera más confiable estructurado.

Configurar LM Studio: Hazlo tuyo

LM Studio Es genial, pero puedes adaptarlo a tus necesidades. Para aquellos de ustedes que no quieren leerlo todo, aquí hay un video para ustedes:

Más poder en el chat: Carpeta de Branch &

A veces solo necesitas un nuevo comienzo sin perder el curso anterior. Exactamente para esto hay «Sucursal»! Esta práctica función, que se encuentra justo debajo del chat, crea una copia de su conversación en curso.

Esto es perfecto, por ejemplo, si ha escrito un nuevo párrafo para su presentación y ahora desea generar un mensaje para una IA de imagen a partir de este último párrafo. Simplemente haga clic en «Branch», cree el nuevo mensaje y copie el resultado en una herramienta externa de creación de imágenes. Mientras tanto, puede continuar con el antiguo historial de chat sin sobrescribir nada.

Hablando de chats: LM Studio Guarda todas tus conversaciones en un menú claro a la izquierda. Aquí puede crear carpetas y ordenar sus chats simplemente arrastrando y soltando. Por lo tanto, también realiza un seguimiento de muchos proyectos.

Ruta de almacenamiento para tus conversaciones

En Mac/Linux puedes encontrarlos aquí:

~/.lmstudio/conversaciones/En Windows, están ahí: (Directorios que comienzan con un . no se ve por defecto. Usos, por tanto, «Mostrar directorios ocultos y de sistema»)

%PERFIL DE USUARIO%\.lmstudio\conversacionesComunidad

Con ojos y sin censura: Modelos de visión & LLM «abliterados»

¿Quieres trabajar no solo con texto, sino también con imágenes? ¡No hay problema! LM Studio soportado Modelos de visión, que puede procesar contenido visual. Solo busque modelos con un símbolo de ojo amarillo, como: Gemma 3 4B. Puede adjuntar imágenes a estos modelos en el chat y pedirles que analicen el contenido o generen mensajes para ello.

Si sus historias o ideas se interponen en el camino de los filtros éticos de las IA normales, también hay una solución: Modelos «sin censura». Estos LLM han sido modificados por la comunidad para tener barreras de seguridad menos estrictas. A menudo puede encontrarlos en la barra de búsqueda de modelos con la palabra clave Aliterado. Pero ten cuidado: Los creadores señalan que estos modelos pueden producir contenido sensible, controvertido o inapropiado. ¡Así que úsalo sabiamente!

El centro de control secreto: Su sistema en LM Studio

Cada poderosa herramienta tiene instrucciones secretas para su uso. Modelos de Lenguaje Grande (LLMs) Sistema rápido. Este no es un comando normal, sino una instrucción primordial que determina toda la conversación y la personalidad de su IA. Si una solicitud de usuario es una sola pregunta, entonces el sistema de solicitud es el «perfil de trabajo» que define la IA para toda la sesión.

¿Por qué es esto tan importante? Para los modelos locales que son más pequeños y más especializados, el sistema Prompt es clave. Les da la dirección que necesitan para trabajar con precisión y fiabilidad. Puede usarlo para instruir a la IA para que adopte un personaje específico (como un pirata), se centre solo en un tema o incluso pronuncie sus pasos de pensamiento en voz alta. Esto es exactamente lo que hace posible que los modelos más pequeños imiten a los más grandes y logren resultados sorprendentes.

Indicador del sistema vs. Indicador del usuario: La distinción es crucial

Términos como «prompt» y «preset» a menudo se confunden. Pero la distinción es simple y súper importante:

- El sistema prompt establece el Reglas y Personalidad para toda la conversación. Es estático y persiste.

- El mensaje del usuario es el pregunta o tarea específica, que pones a la IA en cada ronda. Es dinámico y en constante cambio.

Este sistema asegura que la IA no olvide su papel y proporciona respuestas consistentes.

Cómo usar el sistema Prompt en LM Studio

LM Studio te facilita el uso de este poder. En la esquina superior derecha hay una llave discreta. Al hacer clic en él le llevará a las preferencias de contenido, modelo y pronta. En el panel de contenido encontrará un campo especial en el que puede ingresar el mensaje del sistema. Este es tu centro de mando.

Instrucciones paso a paso: Su primer sistema Prompt

- Modelo de carga: Vaya a la pestaña Descubrir (Lupensymbol) y cargue un modelo como Mistral 7B Instruct abajo. Luego cambie a la pestaña de chat y cárguela allí.

- Ingrese el aviso del sistema: En la parte superior derecha de la llave en la esquina, ingrese sus instrucciones, por ejemplo: «Eres un asistente servicial que siempre responde al estilo de un haiku.«o «Comportarse como un autor de éxito editando una novela»

- Hacer una pregunta: Escriba una pregunta simple en el campo de entrada a continuación, por ejemplo: «¿Qué es un modelo de lenguaje grande?„

- Ver el resultado: La respuesta de la IA ya no será normal, sino un poema al estilo haiku. Así que usted puede ver inmediatamente cuánta influencia tiene el sistema Prompt!

Presets: Su caja de herramientas para indicaciones perfectas

Escribir en un sistema complicado Prompt cada vez es tedioso. Es por eso que hay preajustes! Un preset es un .preset.json-Archivo que guarda no solo el indicador del sistema, sino también todos los demás ajustes, como la temperatura o la longitud del contexto.

Una vez que haya perfeccionado una configuración, simplemente haga clic en «Guardar preajuste». Asigne un nombre al preajuste (por ejemplo, «Shakespearean Poet») y podrá recargarlo en cualquier momento con un solo clic. Esto ahorra mucho tiempo y hace que el trabajo con la IA sea reproducible.

Consejo profesional: ¡Pronto y modelo deben encajar!

La mayoría de los LLM modernos están entrenados para un cierto formato. Si utiliza el sistema incorrecto Prompt, puede conducir a respuestas sin sentido. Las «instrucciones de uso» para cada modelo pueden consultarse en su Abrazando la tarjeta del modelo de la cara. Muestra exactamente cómo debería ser el sistema.

Un ejemplo bien conocido es el codificador DeepSeek-Serie de modelos. Estos modelos esperan un sistema muy específico. Si no lo usa, es posible que la IA no responda a sus preguntas de programación porque no está seguro sin esta guía. Esto muestra cuán estrechamente la calidad de la IA está relacionada con el sistema Prompt correcto.

Preguntas frecuentes (FAQ)

- ¿Por qué necesito el sistema Prompt? Establece las reglas y la personalidad para toda la conversación para que la IA se mantenga consistente y haga exactamente lo que espera que haga.

- ¿Puedo usar un indicador del sistema para todos los modelos? No. Mientras que las indicaciones generales a menudo funcionan, modelos especializados como codificador DeepSeek Un aviso muy específico. ¡Siempre revise primero la página HuggingFace del modelo!

- ¡Mi sistema Prompt no funciona! ¿Qué hacer? Compruebe si el formato del prompt coincide con el modelo. Otro error común es el Parámetros de inferencia en el panel derecho. Si: Prompt Eval Tamaño del lote (n_batch) mucho más pequeño que Longitud del contexto (n_ctx) La IA puede «olvidar» sus propias instrucciones. Intente ajustar ambos valores para obtener los mejores resultados.

Para los usuarios avanzados: La línea de comandos de LM Studio (CLI)

¿Te gusta automatizar cosas y trabajar directamente en la terminal? Entonces es lmsLínea de comandos justo para usted. lms es la herramienta CLI que funciona con LM Studio Le permite scriptear y automatizar sus flujos de trabajo. Esto le permite controlar sus LLM locales directamente desde la terminal.

Importante: Antes de ti lms Puedes usarlo, tienes que LM Studio Empezó al menos una vez.

La instalación es un juego de niños:

- lms bootstappen: Abra su terminal (o PowerShell en Windows) y escriba el siguiente comando

macOS/Linux:

~/.lmstudio/bin/lms bootstrapventanas:

cmd/c %PERFIL DE USUARIO%/.lmstudio/bin/lms.exe bootstrapComprobar la instalación: Comienza nuevo Ventana terminal y simplemente dar lms uno. Debería ver una lista de comandos disponibles.

Los comandos más importantes de un vistazo:

Con estos comandos, puede utilizar las funciones básicas de LM Studio Ejecutar directamente en el terminal:

- Controlar el servidor: Inicie o detenga el servidor local para usar sus modelos a través de la API.

Inicio del servidor lmsParada del servidor lms

- Lista de modelos: Muestra todos los modelos que tiene en su computadora o los que están cargados actualmente.

lms ls(enumera todos los modelos descargados)lms ps(enumera los modelos cargados actualmente)

- Modelos de carga y descarga: Carga un modelo en la memoria o lo elimina.

Incluso puede establecer parámetros como el uso de GPU (--gpu=1,0) y la duración del contexto (--context-length=16384) directamente.

lms carga TheBloke/phi-2-GGUFlms descarga --todos(descarga todos los modelos cargados)

El lms CLI es una herramienta poderosa para cualquier persona que quiera profundizar en el mundo de los LLM locales. ¡Pruébalo y automatiza tus proyectos de IA!

La API: Su clon local de OpenAI

¿No solo desea utilizar sus modelos locales en el chat, sino también integrarlos directamente en sus propias aplicaciones y proyectos? LM Studio lo hace posible. La aplicación proporciona un API compatible con OpenAI Listo, que se siente como el servicio real, solo que todo funciona localmente en su computadora.

Es tan fácil de conectar

Lo ingenioso de esto: Apenas necesita personalizar sus scripts o clientes existentes para OpenAI. Solo cámbialas. URL base sus solicitudes de API para que apunten a su servidor local de LM Studio (http://localhost:1234/v1). Su código cree que se está comunicando con OpenAI, pero en realidad todo permanece en su computadora.

Aquí hay algunos ejemplos de cómo se ve esto en diferentes idiomas:

Python

desde la importación de openai Cliente de OpenAI = OpenAI( base_url="http://localhost:1234/v1" ) # El resto de tu código sigue siendo el mismo.

TipoScript

importar OpenAI desde 'openai'; const client = nuevo OpenAI({ baseUrl: "http://localhost:1234/v1" }); // ... el resto de su código sigue siendo el mismo ...

Idiomas típicos para la conexión API

Además de Python y TipoScript (JavaScript) especialmente estos lenguajes se utilizan a menudo para la conexión de API porque tienen sus propias bibliotecas para interactuar con las API:

- Java: Con clientes HTTP como

OkHttpoApacheHttpClientLas solicitudes REST se pueden enviar fácilmente a la API de LM Studio. También hay bibliotecas cliente OpenAI especiales para Java que puede personalizar. - Ir: La biblioteca estándar de Go (

neto/http) es perfecto para hacer solicitudes HTTP. Es una opción sencilla y eficiente para aplicaciones de backend. - C#: Para los desarrolladores de .NET, el lenguaje con el

HttpClientlas herramientas ideales para conectarse a la API. Aquí también hay paquetes especiales que facilitan la conexión a servicios compatibles con OpenAI. - PHP: PHP se utiliza a menudo en el desarrollo web. Puedes usarlos

cURLextensiones o bibliotecas tales comoGuzzleÚsalo para enviar solicitudes de API. - Ruby: Bibliotecas como

Faradayo el integradoneto/httpLa biblioteca se puede utilizar para controlar la API de LM Studio. - óxido: Si valoras la velocidad y la seguridad, usa Rust. Bibliotecas como

reqwesthacer que las solicitudes de API sean simples y seguras.

La belleza de la Compatibilidad con OpenAI Usted no está limitado a un idioma específico. Mientras pueda personalizar la URL base, el mundo de la programación está abierto para que interactúe con sus LLM locales.

Los principales puntos finales de la API

LM Studio Admite los endpoints OpenAI más comunes para que pueda trabajar sin problemas:

GET /v1/modelos: Muestra todos los modelos que se cargan actualmente en LM Studio. Perfecto para hacer que tus proyectos sean dinámicos.POST /v1/chat/finalizaciones: Este es el punto final principal para el chat. Puede pasar sus conversaciones como un historial de chat y obtener una respuesta de la IA. Aquí el sistema solicita y todos los parámetros (comotemperatura) aplicado automáticamente.POST /v1/embeddings: Ideal para convertir texto en vectores. Esto es especialmente útil para RAG (Retrieval-Augmented Generation), es decir, chatear con sus documentos.POST /v1/finalizaciones: Incluso si OpenAI ya no admite activamente este punto final, puede usarlo en LM Studio utilizar para generar la continuación de un texto. Tenga en cuenta que los modelos de chat pueden mostrar un comportamiento inesperado. Los modelos base son los más adecuados para esta característica.

Con la API de LM Studio No se limita a la interfaz gráfica, sino que puede integrar toda la potencia de su IA local directamente en sus propias herramientas con la sintaxis familiar de OpenAI.

Conclusión: ¡Tu aventura de IA comienza ahora!

¿Lo ves? Ya casi estás LM Studio¡Expertos! Desde descargar tu primer modelo hasta chatear con Llama, has desatado el poder de la IA local. LM Studio Es perfecto para principiantes porque no requiere ninguna habilidad de programación, protege sus datos y le da acceso a una amplia gama de modelos. Paso a paso, también te ofrece excelentes características y opciones avanzadas.

¿Cuál es tu primer proyecto? ¿Un chatbot? ¿Un generador de poesía? ¿O tal vez quieres pedirle a la IA que te ayude con la tarea? No importa qué, ¡diviértete!

Fuentes: LM Studio Masterclass | Cara de abrazo | Guía caliente AI | LMStudio Docs | Comunidad de LMStudio | LMS Discord | LMS Github | @lmstudio